|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

TALE : Cadre de raisonnement LLM prenant en compte le budget des jetons

Dec 29, 2024 at 04:22 pm

Les grands modèles linguistiques (LLM) ont montré un potentiel important dans les tâches de raisonnement, en utilisant des méthodes telles que la chaîne de pensée (CoT) pour décomposer des problèmes complexes en étapes gérables. Cependant, cette capacité comporte des défis. Les invites CoT augmentent souvent l’utilisation des jetons, ce qui entraîne des coûts de calcul et une consommation d’énergie plus élevés. Cette inefficacité est préoccupante pour les applications qui nécessitent à la fois précision et efficacité des ressources. Les LLM actuels ont tendance à générer des résultats inutilement longs, ce qui ne se traduit pas toujours par une meilleure précision mais entraîne des coûts supplémentaires. Le principal défi consiste à trouver un équilibre entre les performances de raisonnement et l’efficacité des ressources.

A recent development in the field of artificial intelligence (AI) aims to address the excessive token usage and high computational costs associated with Chain-of-Thought (CoT) prompting methods for Large Language Models (LLMs). A team of researchers from Nanjing University, Rutgers University, and UMass Amherst have proposed a novel Token-Budget-Aware LLM Reasoning Framework to optimize token efficiency.

Un développement récent dans le domaine de l'intelligence artificielle (IA) vise à remédier à l'utilisation excessive de jetons et aux coûts de calcul élevés associés aux méthodes d'incitation à la chaîne de pensée (CoT) pour les grands modèles linguistiques (LLM). Une équipe de chercheurs de l'Université de Nanjing, de l'Université Rutgers et de l'UMass Amherst ont proposé un nouveau cadre de raisonnement LLM Token-Budget-Aware pour optimiser l'efficacité des jetons.

The framework, named TALE (standing for Token-Budget-Aware LLM rEasoning), operates in two primary stages: budget estimation and token-budget-aware reasoning. Initially, TALE employs techniques like zero-shot prediction or regression-based estimators to assess the complexity of a reasoning task and derive an appropriate token budget. This budget is then seamlessly integrated into the CoT prompt, guiding the LLM to generate concise yet accurate responses.

Le cadre, nommé TALE (pour Token-Budget-Aware LLM rEasoning), fonctionne en deux étapes principales : l'estimation du budget et le raisonnement tenant compte du budget symbolique. Initialement, TALE utilise des techniques telles que la prédiction sans tir ou des estimateurs basés sur la régression pour évaluer la complexité d'une tâche de raisonnement et en dériver un budget symbolique approprié. Ce budget est ensuite intégré de manière transparente dans l'invite CoT, guidant le LLM pour générer des réponses concises mais précises.

A key innovation within TALE is the concept of “Token Elasticity,” which identifies an optimal range of token budgets that minimizes token usage while preserving accuracy. By leveraging iterative search techniques like binary search, TALE can pinpoint the optimal budget for various tasks and LLM architectures. On average, the framework achieves a remarkable 68.64% reduction in token usage with less than a 5% decrease in accuracy, highlighting its effectiveness and practicality for token efficiency.

Une innovation clé au sein de TALE est le concept « d'élasticité des jetons », qui identifie une gamme optimale de budgets de jetons qui minimise l'utilisation des jetons tout en préservant la précision. En tirant parti de techniques de recherche itératives telles que la recherche binaire, TALE peut identifier le budget optimal pour diverses tâches et architectures LLM. En moyenne, le cadre atteint une réduction remarquable de 68,64 % de l'utilisation des jetons avec une diminution de la précision de moins de 5 %, soulignant son efficacité et son caractère pratique pour l'efficience des jetons.

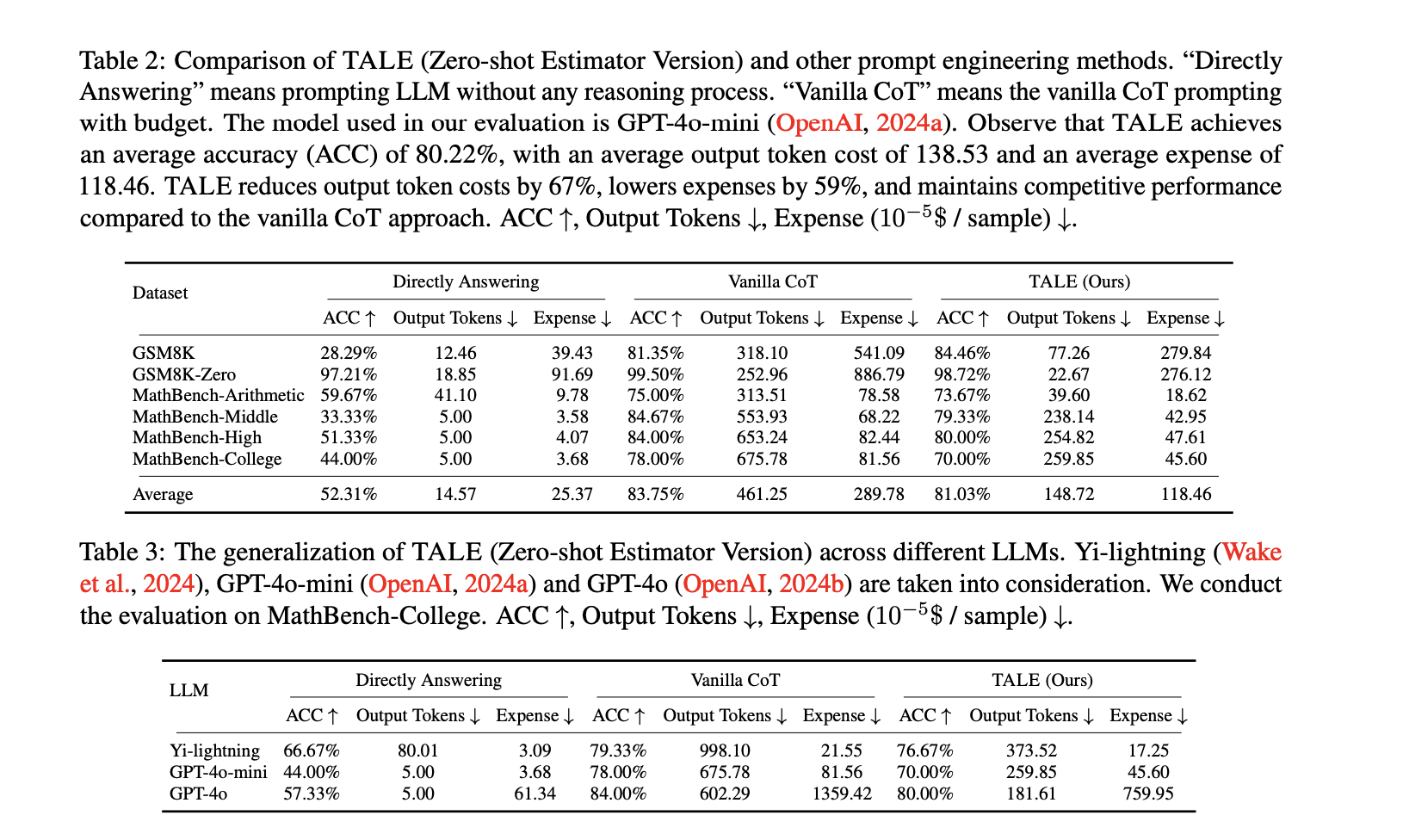

Experiments conducted on standard benchmarks, such as GSM8K and MathBench, showcase TALE's broad applicability and efficiency gains. For instance, on the GSM8K dataset, TALE achieved an impressive 84.46% accuracy, surpassing the Vanilla CoT method while simultaneously reducing token costs from 318.10 to 77.26 on average. When applied to the GSM8K-Zero setting, TALE achieved a stunning 91% reduction in token costs, all while maintaining an accuracy of 98.72%.

Les expériences menées sur des benchmarks standards, tels que GSM8K et MathBench, mettent en valeur la large applicabilité et les gains d'efficacité de TALE. Par exemple, sur l'ensemble de données GSM8K, TALE a atteint une précision impressionnante de 84,46 %, surpassant la méthode Vanilla CoT tout en réduisant simultanément les coûts des jetons de 318,10 à 77,26 en moyenne. Lorsqu'il est appliqué au paramètre GSM8K-Zero, TALE a obtenu une réduction étonnante de 91 % des coûts des jetons, tout en conservant une précision de 98,72 %.

Furthermore, TALE demonstrates strong generalizability across different LLMs, including GPT-4o-mini and Yi-lightning. When employed on the MathBench-College dataset, TALE achieved reductions in token costs of up to 70% while maintaining competitive accuracy. Notably, the framework also leads to significant reductions in operational expenses, cutting costs by 59% on average compared to Vanilla CoT. These results underscore TALE's capability to enhance efficiency without sacrificing performance, making it suitable for a diverse range of applications.

De plus, TALE démontre une forte généralisabilité dans différents LLM, notamment GPT-4o-mini et Yi-lightning. Lorsqu'il est utilisé sur l'ensemble de données MathBench-College, TALE a obtenu des réductions des coûts des jetons allant jusqu'à 70 % tout en conservant une précision compétitive. Notamment, le cadre entraîne également des réductions significatives des dépenses opérationnelles, réduisant les coûts de 59 % en moyenne par rapport à Vanilla CoT. Ces résultats soulignent la capacité de TALE à améliorer l'efficacité sans sacrifier les performances, ce qui le rend adapté à une large gamme d'applications.

In conclusion, the Token-Budget-Aware LLM Reasoning Framework offers a practical solution to the inefficiency of token usage in reasoning tasks. By dynamically estimating and applying token budgets, TALE strikes a crucial balance between accuracy and cost-effectiveness. This approach ultimately reduces computational expenses and broadens the accessibility of advanced LLM capabilities. As AI continues to rapidly evolve, frameworks like TALE pave the way for more efficient and sustainable use of LLMs in both academic and industrial settings.

En conclusion, le cadre de raisonnement LLM Token-Budget-Aware offre une solution pratique à l'inefficacité de l'utilisation des jetons dans les tâches de raisonnement. En estimant et en appliquant dynamiquement des budgets symboliques, TALE atteint un équilibre crucial entre précision et rentabilité. Cette approche réduit finalement les dépenses de calcul et élargit l'accessibilité aux capacités avancées de LLM. Alors que l’IA continue d’évoluer rapidement, des cadres tels que TALE ouvrent la voie à une utilisation plus efficace et durable des LLM dans les contextes universitaires et industriels.

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

- Le prix du bitcoin se débat sur ses cartes quotidiennes alors que les liquidations du marché cryptographique traversent 500 millions de dollars.

- Apr 03, 2025 at 04:40 pm

- Le marché de la cryptographie a pris aujourd'hui un coup notable, à la suite des tensions commerciales des tarifs de Trump et des craintes de l'inflation.

-

-

-

- Ripple intègre son RLUSD stablecoin nouvellement libéré dans sa solution de paiement phare

- Apr 03, 2025 at 04:35 pm

- Ripple a intégré son stablecoin récemment publié, Ripple USD (RLUSD), dans sa solution de paiement phare, Ripple Payments, pour améliorer l'efficacité des transactions transfrontalières.

-

-

-

- Le marché augmentera à mesure que la demande de bitcoin et d'altcoin pourrait augmenter: l'analyste prédit

- Apr 03, 2025 at 04:25 pm

- Hier, le gouvernement américain a imposé des tarifs réciproques à certains de ses partenaires commerciaux éminents, notamment la Chine, le Royaume-Uni et la Corée du Sud.

-

- Les législateurs du Minnesota et de l'Alabama présentent des projets de loi de compagnie pour acheter du bitcoin

- Apr 03, 2025 at 04:25 pm

- Les législateurs de l'État américain du Minnesota et de l'Alabama ont déposé des projets de loi de compagnie à des projets de loi identiques existants qui permettront à chaque État d'acheter du bitcoin.

-

- Les détenteurs de Bitcoin (BTC) qui ont acheté pendant la période de découverte de prix 2020-2021 ne se vendent pas

- Apr 03, 2025 at 04:20 pm

- Les données montrent que les acheteurs de cette période, dont la base du coût varie du plus bas 2020 de 3600 $ au sommet de 2021 de 69000 $, n'ont pas été motivés à vendre