|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

강화 학습(RL)과 대규모 언어 모델(LLM)의 융합은 전산 언어학에 새로운 길을 열어줍니다. LLM은 텍스트를 이해하고 생성하는 탁월한 능력을 갖추고 있지만 교육을 받으려면 답변이 인간의 선호도에 부합하는지 확인해야 하는 문제를 해결해야 합니다. DPO(직접 선호 최적화)는 LLM 교육에 대한 간소화된 접근 방식으로 등장하여 별도의 보상 학습이 필요하지 않습니다. 대신 DPO는 보상 기능을 정책 출력에 직접 통합하여 언어 생성을 보다 세밀하게 제어할 수 있습니다.

Exploring the Synergy between Reinforcement Learning and Large Language Models: Direct Preference Optimization for Enhanced Text Generation

강화 학습과 대규모 언어 모델 간의 시너지 탐색: 향상된 텍스트 생성을 위한 직접 선호도 최적화

The intersection of reinforcement learning (RL) and large language models (LLMs) has emerged as a vibrant field within computational linguistics. These models, initially trained on vast text corpora, exhibit exceptional capabilities in understanding and producing human-like language. As research progresses, the challenge lies in refining these models to effectively capture nuanced human preferences and generate responses that accurately align with specific intents.

강화 학습(RL)과 대규모 언어 모델(LLM)의 교차점은 전산 언어학 내에서 활발한 분야로 부상했습니다. 처음에 방대한 텍스트 말뭉치에 대해 훈련된 이러한 모델은 인간과 유사한 언어를 이해하고 생성하는 데 탁월한 능력을 보여줍니다. 연구가 진행됨에 따라 이러한 모델을 개선하여 미묘한 인간 선호도를 효과적으로 포착하고 특정 의도에 정확하게 부합하는 응답을 생성하는 것이 과제입니다.

Traditional approaches to language model training face limitations in handling the complexity and subtlety required in these tasks. This necessitates advancements that bridge the gap between human expectations and machine output. Reinforcement learning from human feedback (RLHF) frameworks, such as proximal policy optimization (PPO), have been explored for aligning LLMs with human preferences. Further innovations include incorporating Monte Carlo tree search (MCTS) and diffusion models into text generation pipelines, enhancing the quality and adaptability of model responses.

언어 모델 훈련에 대한 전통적인 접근 방식은 이러한 작업에 필요한 복잡성과 미묘함을 처리하는 데 한계가 있습니다. 이를 위해서는 인간의 기대와 기계의 출력 사이의 격차를 해소하는 발전이 필요합니다. PPO(Proximal Policy Optimization)와 같은 인간 피드백(RLHF) 프레임워크로부터의 강화 학습은 LLM을 인간 선호도에 맞추기 위해 연구되었습니다. 추가 혁신에는 MCTS(몬테카를로 트리 검색) 및 확산 모델을 텍스트 생성 파이프라인에 통합하여 모델 응답의 품질과 적응성을 향상시키는 것이 포함됩니다.

Stanford University's Direct Preference Optimization (DPO)

스탠포드 대학교의 직접 선호 최적화(DPO)

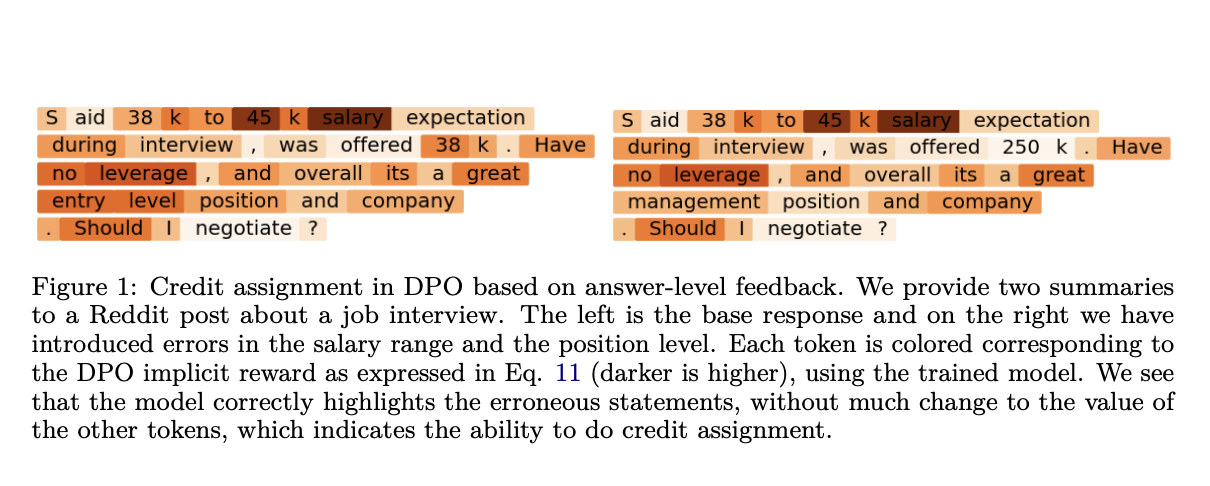

Stanford researchers have developed a streamlined approach for training LLMs known as Direct Preference Optimization (DPO). DPO integrates reward functions directly within policy outputs, eliminating the need for separate reward learning stages. This approach, based on Markov decision processes (MDPs) at the token level, provides finer control over the model's language generation capabilities.

스탠포드 연구진은 DPO(Direct Preference Optimization)로 알려진 LLM 교육을 위한 간소화된 접근 방식을 개발했습니다. DPO는 보상 기능을 정책 출력 내에 직접 통합하므로 별도의 보상 학습 단계가 필요하지 않습니다. 토큰 수준의 MDP(Markov 의사결정 프로세스)를 기반으로 하는 이 접근 방식은 모델의 언어 생성 기능을 보다 세밀하게 제어할 수 있습니다.

Implementation and Evaluation

구현 및 평가

The study employed the Reddit TL;DR summarization dataset to assess the practical efficacy of DPO. Training and evaluation utilized precision-enhancing techniques such as beam search and MCTS, tailored to optimize decision-making at each point in the model's output. These methods facilitated the incorporation of detailed and immediate feedback directly into the policy learning process, effectively improving the relevance and alignment of textual output with human preferences.

이 연구에서는 Reddit TL;DR 요약 데이터세트를 사용하여 DPO의 실질적인 효능을 평가했습니다. 훈련 및 평가에서는 모델 출력의 각 지점에서 의사 결정을 최적화하도록 맞춤화된 빔 검색 및 MCTS와 같은 정밀도 향상 기술을 활용했습니다. 이러한 방법은 상세하고 즉각적인 피드백을 정책 학습 프로세스에 직접 통합하여 텍스트 출력과 인간 선호도의 관련성과 정렬을 효과적으로 개선했습니다.

Quantitative Results

정량적 결과

The implementation of DPO demonstrated measurable improvements in model performance. Employing beam search within the DPO framework yielded a win rate increase of 10-15% on held-out test prompts from the Reddit TL;DR dataset, as evaluated by GPT-4. These results showcase DPO's effectiveness in enhancing the alignment and accuracy of language model responses under specific test conditions.

DPO 구현을 통해 모델 성능이 눈에 띄게 향상되었습니다. GPT-4 평가에 따르면 DPO 프레임워크 내에서 빔 검색을 사용하면 Reddit TL;DR 데이터 세트의 보류 테스트 프롬프트에서 승률이 10-15% 증가했습니다. 이러한 결과는 특정 테스트 조건에서 언어 모델 응답의 정렬 및 정확성을 향상시키는 DPO의 효율성을 보여줍니다.

Conclusion

결론

The research introduced Direct Preference Optimization (DPO), a streamlined approach for training LLMs using a token-level Markov Decision Process. DPO integrates reward functions directly with policy outputs, simplifying the training process and enhancing the accuracy and alignment of language model responses with human feedback. These findings underscore the potential of DPO to advance the development and application of generative AI models.

이 연구에서는 토큰 수준 Markov 결정 프로세스를 사용하여 LLM 교육을 위한 간소화된 접근 방식인 DPO(직접 선호 최적화)를 도입했습니다. DPO는 보상 기능을 정책 출력과 직접 통합하여 교육 프로세스를 단순화하고 언어 모델 응답의 정확성과 인간 피드백의 정렬을 향상시킵니다. 이러한 발견은 생성적 AI 모델의 개발 및 적용을 발전시키는 DPO의 잠재력을 강조합니다.

Contributions to the Field

현장에 대한 기여

- Introduces a novel training approach for LLMs that leverages direct preference optimization.

- Integrates reward functions within policy outputs, eliminating the need for separate reward learning.

- Demonstrates improved model performance and alignment with human preferences, as evidenced by quantitative results on the Reddit TL;DR dataset.

- Simplifies and enhances the training processes of generative AI models.

직접적인 선호도 최적화를 활용하는 LLM을 위한 새로운 교육 접근 방식을 소개합니다. 정책 결과 내에 보상 기능을 통합하여 별도의 보상 학습이 필요하지 않습니다. Reddit TL;DR 데이터 세트의 정량적 결과에서 입증된 것처럼 개선된 모델 성능과 인간 선호도와의 정렬을 보여줍니다. .생성 AI 모델의 훈련 프로세스를 단순화하고 향상합니다.

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.