|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

PRM implicite: un cadre d'apprentissage de renforcement qui élimine le besoin d'annotations par étapes explicites

Feb 08, 2025 at 11:49 am

A group of researchers from Tsinghua University, Shanghai AI Lab, University of Illinois Urbana-Champaign, Peking University, Shanghai Jiaotong University, and CUHK has proposed a reinforcement learning framework that eliminates the need for explicit step-wise annotations using efficient utilization of dense feedback .

Reinforcement learning (RL) for large language models (LLMs) has traditionally relied on outcome-based rewards, which provide feedback only on the final output. This sparsity of reward makes it challenging to train models that need multi-step reasoning, like those employed in mathematical problem-solving and programming. Additionally, credit assignment becomes ambiguous, as the model does not get fine-grained feedback for intermediate steps.

L'apprentissage par renforcement (RL) pour les modèles de grands langues (LLMS) s'est traditionnellement appuyé sur des récompenses basées sur les résultats, qui ne fournissent pas de commentaires uniquement sur la sortie finale. Cette rareté de récompense rend difficile pour former des modèles qui nécessitent un raisonnement en plusieurs étapes, comme ceux utilisés dans la résolution et la programmation mathématiques de problèmes. De plus, l'attribution du crédit devient ambigu, car le modèle n'obtient pas de rétroaction à grain fin pour les étapes intermédiaires.

Process reward models (PRMs) try to address this by offering dense step-wise rewards, but they need costly human-annotated process labels, making them infeasible for large-scale RL. In addition, static reward functions are plagued by overoptimization and reward hacking, where the model takes advantage of the reward system in unforeseen ways, eventually compromising generalization performance. These limitations restrict RL’s efficiency, scalability, and applicability for LLMs, calling for a new solution that effectively combines dense rewards without high computational expense or human annotations.

Les modèles de récompense de processus (PRMS) essaient de résoudre ce problème en offrant des récompenses denses étapes, mais elles ont besoin d'étiquettes de processus annotées humaines coûteuses, ce qui les rend irréalisables pour une RL à grande échelle. De plus, les fonctions de récompense statique sont en proie à une suroptimisation et à un piratage de récompense, où le modèle profite du système de récompense de manière imprévue, compromettant finalement les performances de généralisation. Ces limitations restreignent l'efficacité, l'évolutivité et l'applicabilité de RL pour les LLM, appelant à une nouvelle solution qui combine efficacement des récompenses denses sans dépenses de calcul élevées ni annotations humaines.

Most existing RL methods for LLMs employ outcome reward models (ORMs), which offer scores only for the final output. This results in low sample efficiency as models must generate and test whole sequences before getting feedback. Some methods employ value models that estimate future rewards from past actions to counter this. However, these models have high variance and do not handle reward sparsity properly. PRMs offer more fine-grained feedback but need costly manual annotations for intermediate steps and are prone to reward hacking because of static reward functions. Additionally, most existing methods need an extra training phase for the reward model, adding to the computational expense and making them infeasible for scalable online RL.

La plupart des méthodes RL existantes pour les LLM utilisent les modèles de récompense des résultats (ORMS), qui n'offrent des scores que pour la sortie finale. Il en résulte une faible efficacité de l'échantillon car les modèles doivent générer et tester des séquences entières avant d'obtenir des commentaires. Certaines méthodes utilisent des modèles de valeur qui estiment les récompenses futures des actions passées pour le contrer. Cependant, ces modèles ont une grande variance et ne gèrent pas correctement la rareté de récompense. Les PRM offrent des commentaires plus fins, mais nécessitent des annotations manuelles coûteuses pour les étapes intermédiaires et sont enclins à récompenser le piratage en raison des fonctions de récompense statique. De plus, la plupart des méthodes existantes ont besoin d'une phase de formation supplémentaire pour le modèle de récompense, ajoutant aux dépenses de calcul et les rendant irréalisables pour une RL en ligne évolutive.

A group of researchers from Tsinghua University, Shanghai AI Lab, University of Illinois Urbana-Champaign, Peking University, Shanghai Jiaotong University, and CUHK has proposed a reinforcement learning framework that eliminates the need for explicit step-wise annotations using efficient utilization of dense feedback. The main contribution proposed is the introduction of an Implicit Process Reward Model (Implicit PRM), which produces token-level rewards independently of outcome labels, thus eliminating the need for human-annotated step-level guidance. The approach allows for continuous online improvement of the reward model, eliminating the problem of overoptimization without allowing dynamic policy rollout adjustments. The framework can successfully integrate implicit process rewards with outcome rewards during advantage estimation, offering computational efficiency and eliminating reward hacking. Unlike previous methods, which require a separate training phase for process rewards, the new approach initializes the PRM directly from the policy model itself, thus greatly eliminating developmental overhead. It is also made compatible with a range of RL algorithms, including REINFORCE, PPO, and GRPO, thus making it generalizable and scalable for training large language models (LLMs).

A group of researchers from Tsinghua University, Shanghai AI Lab, University of Illinois Urbana-Champaign, Peking University, Shanghai Jiaotong University, and CUHK has proposed a reinforcement learning framework that eliminates the need for explicit step-wise annotations using efficient utilization of dense feedback . La principale contribution proposée est l'introduction d'un modèle de récompense de processus implicite (PRM implicite), qui produit des récompenses au niveau des jetons indépendamment des étiquettes de résultat, éliminant ainsi le besoin de guidage de pas annoté par l'homme. L'approche permet une amélioration continue en ligne du modèle de récompense, éliminant le problème de la suroptimisation sans permettre des ajustements de déploiement de politique dynamique. Le cadre peut intégrer avec succès les récompenses de processus implicites avec les récompenses des résultats pendant l'estimation de l'avantage, offrant une efficacité de calcul et éliminer le piratage de récompense. Contrairement aux méthodes précédentes, qui nécessitent une phase de formation distincte pour les récompenses de processus, la nouvelle approche initialise le PRM directement à partir du modèle de politique lui-même, éliminant ainsi considérablement les frais généraux de développement. Il est également rendu compatible avec une gamme d'algorithmes RL, y compris le renforcement, le PPO et le GRPO, ce qui le rend généralisable et évolutif pour la formation de modèles de langues (LLM).

This reinforcement learning system provides token-level implicit process rewards, calculated through a log-ratio formulation between a learned reward model and a reference model. Rather than manual annotation, the reward function is learned from raw outcome labels, which are already obtained for policy training. The system also includes online learning of the reward function to avoid overoptimization and reward hacking. It uses a hybrid advantage estimation approach that combines implicit process and outcome rewards through a leave-one-out Monte Carlo estimator. Policy optimization is achieved through Proximal Policy Optimisation (PPO) using a clipped surrogate loss function for stability. The model was trained using Qwen2.5-Math-7B-Base, an optimized model for mathematical reasoning. The system is based on 150K queries with four samples per query, compared to Qwen2.5-Math-7B-Instruct using 618K in-house annotations, which demonstrates the effectiveness of the training process.

Ce système d'apprentissage par renforcement fournit des récompenses de processus implicites au niveau du jeton, calculées par une formulation log-ratio entre un modèle de récompense apprise et un modèle de référence. Plutôt que l'annotation manuelle, la fonction de récompense est apprise des étiquettes de résultats brutes, qui sont déjà obtenues pour la formation politique. Le système comprend également l'apprentissage en ligne de la fonction de récompense pour éviter la suroptimisation et le piratage de récompense. Il utilise une approche d'estimation de l'avantage hybride qui combine des récompenses implicites de processus et de résultats grâce à un estimateur de Monte Carlo à un seul coup. L'optimisation des politiques est obtenue grâce à l'optimisation de la politique proximale (PPO) en utilisant une fonction de perte de substitution coupée pour la stabilité. Le modèle a été formé à l'aide de la base QWEN2.5-Math-7B, un modèle optimisé pour le raisonnement mathématique. Le système est basé sur 150 000 requêtes avec quatre échantillons par requête, par rapport à Qwen2.5-Math-7B-Istruct en utilisant des annotations internes 618k, ce qui démontre l'efficacité du processus de formation.

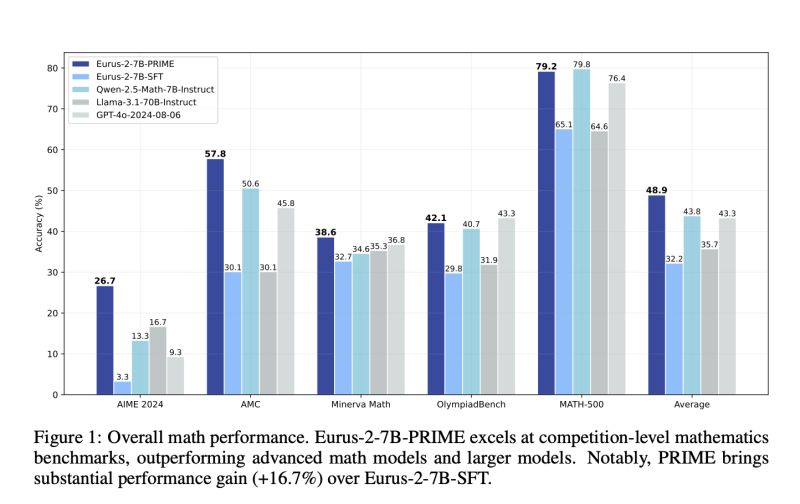

The reinforcement learning system demonstrates significant gains in sample efficiency and reasoning performance across several benchmarks. It provides a 2.5× gain in sample efficiency and a 6.9% gain in mathematical problem-solving compared to standard outcome-based RL. The model outperforms Qwen2.5-Math-7B-Instruct on benchmarking mathematical benchmarks, with better accuracy on competition-level tasks like AIME and AMC. Models trained from this process outperform larger models, including GPT-4o, by pass@1 accuracy for challenging reasoning tasks, even when using only 10% of the training data used by Qwen2.5-Math-7B-Instruct. The results affirm that online updates to the reward model avoid over-optimization, enhance training stability, and enhance credit assignment, making it an extremely powerful method for reinforcement learning in LLMs.

Le système d'apprentissage par renforcement démontre des gains importants dans l'efficacité de l'échantillon et les performances du raisonnement à travers plusieurs repères. Il fournit un gain de 2,5 × en efficacité de l'échantillon et un gain de 6,9% en résolution de problèmes mathématiques par rapport à la RL basée sur les résultats standard. Le modèle surpasse l'instruction QWEN2.5-Math-7B sur les références mathématiques compliquées, avec une meilleure précision sur les tâches au niveau de la compétition comme l'AIME et l'AMC. Les modèles formés à partir de ce processus surpassent les modèles plus importants, y compris le GPT-4O, par PASS @ 1 précision pour des tâches de raisonnement difficiles, même lorsque vous n'utilisez que 10% des données de formation utilisées par QWEN2.5-Math-7B-instruct. Les résultats affirment que les mises à jour en ligne du modèle de récompense évitent la sur-optimisation, améliorent la stabilité de la formation et améliorent la mission de crédit, ce qui en fait une méthode extrêmement puissante pour l'apprentissage du renforcement dans les LLM.

This reinforcement learning approach provides an efficient and scalable LLM training process with dense implicit process rewards. This eliminates step-level explicit annotations and minimizes training costs while enhancing sample efficiency, stability, and performance. The process combines online reward modeling and token-level feedback harmoniously, solving long-standing problems of reward sparsity and credit assignment in RL for LLMs. These improvements optimize reasoning capability in AI models and make them suitable for problem-solving applications in mathematics and programming. This research is a substantial contribution to RL-based L

Cette approche d'apprentissage par renforcement fournit un processus de formation LLM efficace et évolutif avec des récompenses de processus implicites denses. Cela élimine les annotations explicites au niveau des étapes et minimise les coûts de formation tout en améliorant l'efficacité des échantillons, la stabilité et les performances. Le processus combine la modélisation de récompense en ligne et la rétroaction au niveau des jetons harmonieusement, résolvant des problèmes de longue durée de récompense et d'affectation de crédit dans RL pour les LLM. Ces améliorations optimisent la capacité de raisonnement dans les modèles d'IA et les rendent adaptées aux applications de résolution de problèmes en mathématiques et en programmation. Cette recherche est une contribution substantielle au L basé sur RL

Clause de non-responsabilité:info@kdj.com

The information provided is not trading advice. kdj.com does not assume any responsibility for any investments made based on the information provided in this article. Cryptocurrencies are highly volatile and it is highly recommended that you invest with caution after thorough research!

If you believe that the content used on this website infringes your copyright, please contact us immediately (info@kdj.com) and we will delete it promptly.

-

-

- Panshibi ($ shibi) apparaît comme une alternative forte à Shiba Inu (Shib) au milieu de l'évolution du marché

- Feb 08, 2025 at 06:41 pm

- Les politiques économiques de l'administration Trump affectent actuellement les pièces établies comme Shiba Inu (Shib), conduisant à des difficultés et impactant le sentiment des investisseurs.

-

- Mooshot: Le projet de crypto émergent fait des vagues sur le marché

- Feb 08, 2025 at 06:41 pm

- Le marché de la cryptographie peut être volatile, mais cela n'a pas empêché Mooshot de faire des vagues. Le projet Crypto en promenade a déjà collecté plus de 500 000 $ dans sa prévente, et Momentum ne montre aucun signe de ralentissement.

-

- Nous avons demandé à l'IA de prédire le prix OnyxCoin (XCN) lorsque XRP atteint 5 $

- Feb 08, 2025 at 06:41 pm

- Une autre semaine faible pour la crypto est sur le point d'être derrière nous. Bitcoin n'a pas réussi à récupérer 100 000 $ tandis que tous les altcoins, y compris ETH et XRP, n'ont pas réussi à construire

-

- Circle a frappé 250 millions de dollars USDC sur Solana, portant le total à 6,75 milliards de dollars cette année

- Feb 08, 2025 at 06:41 pm

- Circle a attiré l'attention après s'être engagé dans des événements de frappe cruciaux sur la blockchain Solana. Selon les données rapportées par l'analyste cryptographique Onchain Lens

-

- L'investissement stratégique de BlackRock dans la stratégie (anciennement Microstrategy) met en évidence l'intérêt croissant pour les actifs numériques et le bitcoin

- Feb 08, 2025 at 06:41 pm

- BlackRock, la plus grande société de gestion d'actifs au monde, a considérablement augmenté sa participation dans la stratégie (anciennement connue sous le nom de MicroStrategy), ce qui augmente sa propriété à 5%

-

-

-

- ARCTIC PABLO CONOR: Laisse l'aventure avec les meilleures pièces de monnaie dans lesquelles investir à long terme

- Feb 08, 2025 at 06:31 pm

- Le monde des pièces MEME se développe rapidement, avec de nouveaux projets émergeant presque tous les jours. Mais ce qui fait ressortir une pièce de mèmes dans un espace aussi compétitif