|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Tsinghua University, Shanghai AI Lab, 일리노이 대학교 Urbana-Champaign, Peking University, Shanghai Jiaotong University 및 CUHK의 연구원 그룹은 조밀 한 피드백을 효율적으로 활용하여 명시 적 단계 주석을 제거하는 강화 학습 프레임 워크를 제안했습니다. .

Reinforcement learning (RL) for large language models (LLMs) has traditionally relied on outcome-based rewards, which provide feedback only on the final output. This sparsity of reward makes it challenging to train models that need multi-step reasoning, like those employed in mathematical problem-solving and programming. Additionally, credit assignment becomes ambiguous, as the model does not get fine-grained feedback for intermediate steps.

대형 언어 모델 (LLMS)에 대한 강화 학습 (RL)은 전통적으로 결과 기반 보상에 의존하여 최종 출력에 대한 피드백 만 제공합니다. 이러한 보상의 희소성은 수학적 문제 해결 및 프로그래밍에 사용 된 것과 같이 다단계 추론이 필요한 모델을 훈련시키는 데 어려움을 겪습니다. 또한 모델이 중간 단계에 대한 세밀한 피드백을 얻지 못하므로 신용 할당이 모호 해집니다.

Process reward models (PRMs) try to address this by offering dense step-wise rewards, but they need costly human-annotated process labels, making them infeasible for large-scale RL. In addition, static reward functions are plagued by overoptimization and reward hacking, where the model takes advantage of the reward system in unforeseen ways, eventually compromising generalization performance. These limitations restrict RL’s efficiency, scalability, and applicability for LLMs, calling for a new solution that effectively combines dense rewards without high computational expense or human annotations.

프로세스 보상 모델 (PRMS)은 조밀 한 단계별 보상을 제공하여이를 해결하려고 노력하지만 비용이 많이 드는 인간이 발표 된 프로세스 레이블이 필요하므로 대규모 RL에 대해 불가능합니다. 또한, 정적 보상 기능은 과잉 최적화 및 보상 해킹에 시달리며, 여기서 모델은 예상치 못한 방식으로 보상 시스템을 이용하여 결국 일반화 성능을 손상시킵니다. 이러한 한계는 LLM에 대한 RL의 효율성, 확장 성 및 적용 가능성을 제한하여 높은 계산 비용이나 인간 주석없이 밀집된 보상을 효과적으로 결합하는 새로운 솔루션을 요구합니다.

Most existing RL methods for LLMs employ outcome reward models (ORMs), which offer scores only for the final output. This results in low sample efficiency as models must generate and test whole sequences before getting feedback. Some methods employ value models that estimate future rewards from past actions to counter this. However, these models have high variance and do not handle reward sparsity properly. PRMs offer more fine-grained feedback but need costly manual annotations for intermediate steps and are prone to reward hacking because of static reward functions. Additionally, most existing methods need an extra training phase for the reward model, adding to the computational expense and making them infeasible for scalable online RL.

LLM에 대한 대부분의 기존 RL 방법은 결과 보상 모델 (ORM)을 사용하며 최종 출력에 대해서만 점수를 제공합니다. 이로 인해 모델이 피드백을 얻기 전에 전체 시퀀스를 생성하고 테스트해야하므로 샘플 효율이 낮습니다. 일부 방법은 과거의 행동으로부터 미래 보상을 추정하여 이에 대응하는 가치 모델을 사용합니다. 그러나 이러한 모델은 차이가 높고 보상 스파이도를 올바르게 처리하지 않습니다. PRM은 더 세밀한 피드백을 제공하지만 중간 단계에 대한 비용이 많이 드는 수동 주석이 필요하며 정적 보상 기능으로 인해 해킹을 보상하기 쉽습니다. 또한 대부분의 기존 방법에는 보상 모델을위한 추가 교육 단계가 필요하므로 계산 비용을 추가하고 확장 가능한 온라인 RL에 대해 불가능합니다.

A group of researchers from Tsinghua University, Shanghai AI Lab, University of Illinois Urbana-Champaign, Peking University, Shanghai Jiaotong University, and CUHK has proposed a reinforcement learning framework that eliminates the need for explicit step-wise annotations using efficient utilization of dense feedback. The main contribution proposed is the introduction of an Implicit Process Reward Model (Implicit PRM), which produces token-level rewards independently of outcome labels, thus eliminating the need for human-annotated step-level guidance. The approach allows for continuous online improvement of the reward model, eliminating the problem of overoptimization without allowing dynamic policy rollout adjustments. The framework can successfully integrate implicit process rewards with outcome rewards during advantage estimation, offering computational efficiency and eliminating reward hacking. Unlike previous methods, which require a separate training phase for process rewards, the new approach initializes the PRM directly from the policy model itself, thus greatly eliminating developmental overhead. It is also made compatible with a range of RL algorithms, including REINFORCE, PPO, and GRPO, thus making it generalizable and scalable for training large language models (LLMs).

Tsinghua University, Shanghai AI Lab, 일리노이 대학교 Urbana-Champaign, Peking University, Shanghai Jiaotong University 및 CUHK의 연구원 그룹은 조밀 한 피드백을 효율적으로 활용하여 명시 적 단계 주석을 제거하는 강화 학습 프레임 워크를 제안했습니다. . 제안 된 주요 기여는 암시 적 프로세스 보상 모델 (암시 적 PRM)의 도입으로, 결과 레이블과 독립적으로 토큰 수준의 보상을 생성하므로 인간이 주어진 단계 수준 지침이 필요하지 않습니다. 이 접근법은 보상 모델의 지속적인 온라인 개선을 허용하여 동적 정책 롤아웃 조정을 허용하지 않고 과도한 최적화 문제를 제거 할 수 있습니다. 이 프레임 워크는 이점 추정 중에 암시 적 프로세스 보상을 결과 보상과 성공적으로 통합하여 계산 효율성을 제공하고 보상 해킹을 제거 할 수 있습니다. 프로세스 보상을위한 별도의 교육 단계가 필요한 이전 방법과 달리, 새로운 접근법은 PRM을 정책 모델 자체로부터 직접 초기화하므로 발달 오버 헤드가 크게 제거됩니다. 또한 Inwenforce, PPO 및 GRPO를 포함한 다양한 RL 알고리즘과 호환되므로 LLM (Lange Language Model) 교육을 위해 일반화 가능하고 확장 할 수 있습니다.

This reinforcement learning system provides token-level implicit process rewards, calculated through a log-ratio formulation between a learned reward model and a reference model. Rather than manual annotation, the reward function is learned from raw outcome labels, which are already obtained for policy training. The system also includes online learning of the reward function to avoid overoptimization and reward hacking. It uses a hybrid advantage estimation approach that combines implicit process and outcome rewards through a leave-one-out Monte Carlo estimator. Policy optimization is achieved through Proximal Policy Optimisation (PPO) using a clipped surrogate loss function for stability. The model was trained using Qwen2.5-Math-7B-Base, an optimized model for mathematical reasoning. The system is based on 150K queries with four samples per query, compared to Qwen2.5-Math-7B-Instruct using 618K in-house annotations, which demonstrates the effectiveness of the training process.

이 강화 학습 시스템은 학습 된 보상 모델과 참조 모델 사이의 로그-비율 공식을 통해 계산 된 토큰 수준의 암시 적 프로세스 보상을 제공합니다. 보상 기능은 수동 주석 대신 정책 교육을 위해 이미 얻은 원시 결과 레이블에서 배우게됩니다. 이 시스템에는 과도한 최적화 및 보상 해킹을 피하기 위해 보상 기능에 대한 온라인 학습도 포함됩니다. 그것은 휴가 출력 Monte Carlo Estimator를 통해 암시 적 프로세스와 결과 보상을 결합한 하이브리드 우위 추정 접근법을 사용합니다. 정책 최적화는 안정성을 위해 클리핑 대리 손실 함수를 사용하여 근위 정책 최적화 (PPO)를 통해 달성됩니다. 이 모델은 수학적 추론을위한 최적화 된 모델 인 QWEN2.5-MATH-7B-BASE를 사용하여 교육을 받았습니다. 이 시스템은 618K 사내 주석을 사용한 QWEN2.5-MATH-7B- 강조와 비교하여 쿼리 당 4 개의 샘플이있는 150K 쿼리를 기반으로하며 교육 프로세스의 효과를 보여줍니다.

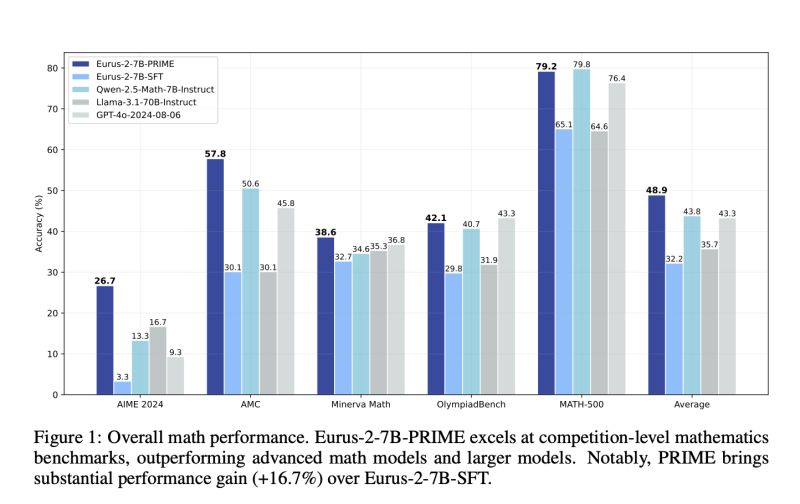

The reinforcement learning system demonstrates significant gains in sample efficiency and reasoning performance across several benchmarks. It provides a 2.5× gain in sample efficiency and a 6.9% gain in mathematical problem-solving compared to standard outcome-based RL. The model outperforms Qwen2.5-Math-7B-Instruct on benchmarking mathematical benchmarks, with better accuracy on competition-level tasks like AIME and AMC. Models trained from this process outperform larger models, including GPT-4o, by pass@1 accuracy for challenging reasoning tasks, even when using only 10% of the training data used by Qwen2.5-Math-7B-Instruct. The results affirm that online updates to the reward model avoid over-optimization, enhance training stability, and enhance credit assignment, making it an extremely powerful method for reinforcement learning in LLMs.

강화 학습 시스템은 여러 벤치 마크에서 샘플 효율성과 추론 성능이 상당한 이익을 보여줍니다. 표준 결과 기반 RL에 비해 샘플 효율이 2.5 × 증가하고 수학적 문제 해결에서 6.9% 증가를 제공합니다. 이 모델은 Aime 및 AMC와 같은 경쟁 수준 작업에 대한 정확성이 향상되어 수학적 벤치 마크를 벤치마킹하는 QWEN2.5-MATH-7B 추천을 능가합니다. 이 프로세스에서 훈련 된 모델은 QWEN2.5-MATH-7B 비수 구조에서 사용한 교육 데이터의 10% 만 사용하는 경우에도 GPT-4O를 포함한 대규모 모델을보다 우수한 추론 작업을위한 패스@1 정확도로 우수합니다. 결과는 보상 모델에 대한 온라인 업데이트가 과도한 최적화를 피하고 교육 안정성을 향상 시키며 신용 할당을 향상시켜 LLM의 강화 학습을위한 매우 강력한 방법이라는 것을 확인합니다.

This reinforcement learning approach provides an efficient and scalable LLM training process with dense implicit process rewards. This eliminates step-level explicit annotations and minimizes training costs while enhancing sample efficiency, stability, and performance. The process combines online reward modeling and token-level feedback harmoniously, solving long-standing problems of reward sparsity and credit assignment in RL for LLMs. These improvements optimize reasoning capability in AI models and make them suitable for problem-solving applications in mathematics and programming. This research is a substantial contribution to RL-based L

이 강화 학습 접근법은 밀집된 과정 보상으로 효율적이고 확장 가능한 LLM 교육 프로세스를 제공합니다. 이를 통해 단계 수준의 명시 적 주석이 제거되고 샘플 효율성, 안정성 및 성능을 향상시키는 동시에 교육 비용을 최소화합니다. 이 과정은 온라인 보상 모델링과 토큰 수준의 피드백을 조화롭게 결합하여 LLM에 대한 RL의 보상 스파이시와 신용 할당의 장기적인 문제를 해결합니다. 이러한 개선 사항은 AI 모델에서 추론 기능을 최적화하고 수학 및 프로그래밍에서 문제 해결 응용 프로그램에 적합합니다. 이 연구는 RL 기반 L에 대한 상당한 기여입니다

부인 성명:info@kdj.com

The information provided is not trading advice. kdj.com does not assume any responsibility for any investments made based on the information provided in this article. Cryptocurrencies are highly volatile and it is highly recommended that you invest with caution after thorough research!

If you believe that the content used on this website infringes your copyright, please contact us immediately (info@kdj.com) and we will delete it promptly.