|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

Implizite PRM: Ein Verstärkungslerngerüst, der die Notwendigkeit expliziter schrittweise Anmerkungen beseitigt

Feb 08, 2025 at 11:49 am

Eine Gruppe von Forschern der Tsinghua University, der Shanghai AI Lab, der University of Illinois Urbana-Champaign, der Peking University, der Shanghai Jiaotong University und CUHK hat einen Verstärkungs-Lernrahmen vorgeschlagen, der die Notwendigkeit einer expliziten stufenweisen Annotationen ausschließt, indem sie die effiziente Nutzung der dichten Rückkopplung benötigt .

Reinforcement learning (RL) for large language models (LLMs) has traditionally relied on outcome-based rewards, which provide feedback only on the final output. This sparsity of reward makes it challenging to train models that need multi-step reasoning, like those employed in mathematical problem-solving and programming. Additionally, credit assignment becomes ambiguous, as the model does not get fine-grained feedback for intermediate steps.

Das Verstärkungslernen (RL) für große Sprachmodelle (LLMs) hat sich traditionell auf ergebnisbasierte Belohnungen verlassen, die nur Feedback für die endgültige Ausgabe liefern. Diese Sparsität der Belohnung macht es schwierig, Modelle zu schulen, die eine multi-stufige Argumentation benötigen, wie sie in mathematischer Problemlösung und Programmierung eingesetzt werden. Darüber hinaus wird die Kreditzuordnung mehrdeutig, da das Modell kein feinkörniges Feedback für Zwischenschritte erhält.

Process reward models (PRMs) try to address this by offering dense step-wise rewards, but they need costly human-annotated process labels, making them infeasible for large-scale RL. In addition, static reward functions are plagued by overoptimization and reward hacking, where the model takes advantage of the reward system in unforeseen ways, eventually compromising generalization performance. These limitations restrict RL’s efficiency, scalability, and applicability for LLMs, calling for a new solution that effectively combines dense rewards without high computational expense or human annotations.

Prozessbelohnungsmodelle (PRMS) versuchen, dies zu beheben, indem sie dichte schrittweise Belohnungen anbieten. Sie benötigen jedoch kostspielige, von Menschen ankündigte Prozessetiketten, wodurch sie für groß angelegte RL nicht realisierbar sind. Darüber hinaus werden statische Belohnungsfunktionen von Überoptimierung und Belohnungshacking geplagt, wobei das Modell das Belohnungssystem auf unvorhergesehene Weise ausnutzt und schließlich die Leistung der Generalisierung beeinträchtigt. Diese Einschränkungen beschränken die Effizienz, Skalierbarkeit und Anwendbarkeit von RL für LLMs und fordern eine neue Lösung, die dichte Belohnungen ohne hohe Rechenaufwand oder menschliche Anmerkungen effektiv kombiniert.

Most existing RL methods for LLMs employ outcome reward models (ORMs), which offer scores only for the final output. This results in low sample efficiency as models must generate and test whole sequences before getting feedback. Some methods employ value models that estimate future rewards from past actions to counter this. However, these models have high variance and do not handle reward sparsity properly. PRMs offer more fine-grained feedback but need costly manual annotations for intermediate steps and are prone to reward hacking because of static reward functions. Additionally, most existing methods need an extra training phase for the reward model, adding to the computational expense and making them infeasible for scalable online RL.

Die meisten vorhandenen RL -Methoden für LLMs verwenden ORMs (Outcome Belohnungsmodelle), die nur für die endgültige Ausgabe Punkte bieten. Dies führt zu einer geringen Probeneffizienz, da Modelle vor dem Erzielen von Feedback ganze Sequenzen generieren und testen müssen. Einige Methoden verwenden Wertungsmodelle, die zukünftige Belohnungen aus früheren Maßnahmen schätzen, um dem entgegenzuwirken. Diese Modelle weisen jedoch eine hohe Varianz auf und handhaben nicht ordnungsgemäß mit der Belohnungsrestinalität um. PRMs bieten ein feinkörnigeres Feedback, benötigen jedoch kostspielige manuelle Annotationen für Zwischenschritte und sind aufgrund statischer Belohnungsfunktionen anfällig für Belohnungshackungen. Darüber hinaus benötigen die meisten vorhandenen Methoden eine zusätzliche Trainingsphase für das Belohnungsmodell, wodurch die Rechenaufwand erhöht und sie für skalierbare Online -RL nicht realisierbar sind.

A group of researchers from Tsinghua University, Shanghai AI Lab, University of Illinois Urbana-Champaign, Peking University, Shanghai Jiaotong University, and CUHK has proposed a reinforcement learning framework that eliminates the need for explicit step-wise annotations using efficient utilization of dense feedback. The main contribution proposed is the introduction of an Implicit Process Reward Model (Implicit PRM), which produces token-level rewards independently of outcome labels, thus eliminating the need for human-annotated step-level guidance. The approach allows for continuous online improvement of the reward model, eliminating the problem of overoptimization without allowing dynamic policy rollout adjustments. The framework can successfully integrate implicit process rewards with outcome rewards during advantage estimation, offering computational efficiency and eliminating reward hacking. Unlike previous methods, which require a separate training phase for process rewards, the new approach initializes the PRM directly from the policy model itself, thus greatly eliminating developmental overhead. It is also made compatible with a range of RL algorithms, including REINFORCE, PPO, and GRPO, thus making it generalizable and scalable for training large language models (LLMs).

Eine Gruppe von Forschern der Tsinghua University, der Shanghai AI Lab, der University of Illinois Urbana-Champaign, der Peking University, der Shanghai Jiaotong University und CUHK hat einen Verstärkungs-Lernrahmen vorgeschlagen, der die Notwendigkeit einer expliziten stufenweisen Annotationen ausschließt, indem sie die effiziente Nutzung der dichten Rückkopplung benötigt . Der vorgeschlagene Hauptbeitrag ist die Einführung eines impliziten Prozessbelohnungsmodells (implizites PRM), das unabhängig von Ergebnisbezeichnungen auf Token-Ebene zu Belohnungen erzeugt wird, wodurch die Notwendigkeit von menschlichem Annotierter stufenloser Führung beseitigt. Der Ansatz ermöglicht eine kontinuierliche Online -Verbesserung des Belohnungsmodells und beseitigt das Problem der Überoptimierung, ohne dass dynamische Rollout -Anpassungen zu ermöglichen. Das Framework kann implizite Prozessprämien erfolgreich mit den Ergebnisempflichtigen während der Vorteilsschätzung integrieren, die Recheneffizienz bieten und Belohnungshacking beseitigen. Im Gegensatz zu früheren Methoden, die eine separate Trainingsphase für Prozessbelohnungen erfordern, initialisiert der neue Ansatz das PRM direkt aus dem politischen Modell selbst und beseitigt so den Entwicklungsaufwand stark. Es wird auch mit einer Reihe von RL -Algorithmen kompatibel, einschließlich Verstärkung, PPO und GRPO, wodurch es verallgemeinerbar und skalierbar ist, um Großsprachenmodelle (LLMs) zu trainieren.

This reinforcement learning system provides token-level implicit process rewards, calculated through a log-ratio formulation between a learned reward model and a reference model. Rather than manual annotation, the reward function is learned from raw outcome labels, which are already obtained for policy training. The system also includes online learning of the reward function to avoid overoptimization and reward hacking. It uses a hybrid advantage estimation approach that combines implicit process and outcome rewards through a leave-one-out Monte Carlo estimator. Policy optimization is achieved through Proximal Policy Optimisation (PPO) using a clipped surrogate loss function for stability. The model was trained using Qwen2.5-Math-7B-Base, an optimized model for mathematical reasoning. The system is based on 150K queries with four samples per query, compared to Qwen2.5-Math-7B-Instruct using 618K in-house annotations, which demonstrates the effectiveness of the training process.

Dieses Verstärkungslernsystem bietet implizite Prozessbelohnungen auf Token-Ebene, die durch eine Log-Verhältnis-Formulierung zwischen einem gelernten Belohnungsmodell und einem Referenzmodell berechnet werden. Anstelle einer manuellen Annotation wird die Belohnungsfunktion aus Roh -Ergebnisbezeichnungen gelernt, die bereits für die Richtlinienschulung erhalten werden. Das System enthält auch das Online -Erlernen der Belohnungsfunktion, um eine Überoptimierung und Belohnung zu vermeiden. Es verwendet einen Hybridvorteilschätzungsansatz, der impliziten Prozess und Ergebnisprämien durch einen Monte-Carlo-Schätzer für einen Leave-Out-Out kombiniert. Die Politikoptimierung wird durch proximale Richtlinienoptimierung (PPO) unter Verwendung einer abgeschnittenen Ersatzverlustfunktion für die Stabilität erreicht. Das Modell wurde unter Verwendung von QWEN2.5-Math-7b-Base trainiert, einem optimierten Modell für mathematisches Denken. Das System basiert auf 150K-Abfragen mit vier Proben pro Abfrage im Vergleich zu QWEN2.5-Math-7B-Struktur unter Verwendung von 618K-Inhouse-Annotationen, was die Wirksamkeit des Trainingsprozesses zeigt.

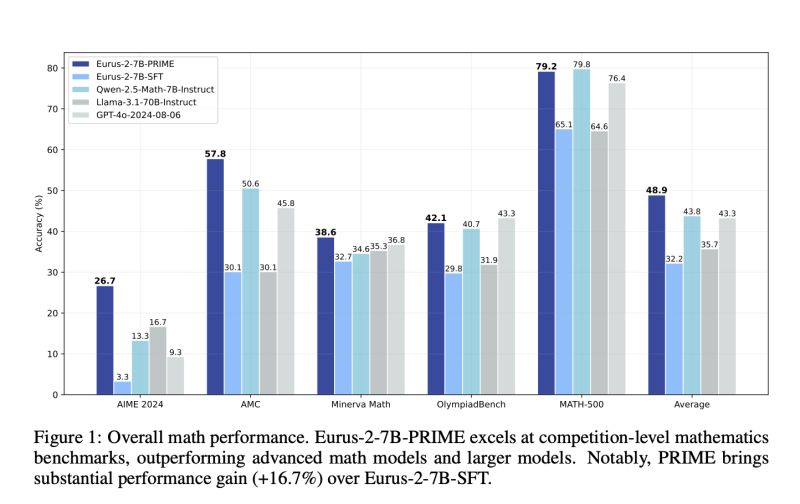

The reinforcement learning system demonstrates significant gains in sample efficiency and reasoning performance across several benchmarks. It provides a 2.5× gain in sample efficiency and a 6.9% gain in mathematical problem-solving compared to standard outcome-based RL. The model outperforms Qwen2.5-Math-7B-Instruct on benchmarking mathematical benchmarks, with better accuracy on competition-level tasks like AIME and AMC. Models trained from this process outperform larger models, including GPT-4o, by pass@1 accuracy for challenging reasoning tasks, even when using only 10% of the training data used by Qwen2.5-Math-7B-Instruct. The results affirm that online updates to the reward model avoid over-optimization, enhance training stability, and enhance credit assignment, making it an extremely powerful method for reinforcement learning in LLMs.

Das Verstärkungslernsystem zeigt signifikante Gewinne der Probeneffizienz und der Argumentationsleistung über mehrere Benchmarks. Es bietet einen 2,5-fach-Verstärkung der Probeneffizienz und einen Anstieg der mathematischen Problemlösung um 6,9% im Vergleich zu Standard-Ergebnis-basierten RL. Das Modell übertrifft Qwen2.5-Math-7B-Struktur auf Benchmarking-mathematischen Benchmarks mit einer besseren Genauigkeit auf Aufgaben auf Wettbewerbsebene wie Aime und AMC. Modelle, die aus diesem Prozess geschult wurden, übertreffen größere Modelle, einschließlich GPT-4O, durch Pass@1 Genauigkeit für herausfordernde Argumentationsaufgaben, selbst wenn nur 10% der Trainingsdaten verwendet werden, die von QWEN2.5-MATH-7B-Instruktur verwendet werden. Die Ergebnisse bestätigen, dass Online-Updates für das Belohnungsmodell Überoptimierung vermeiden, die Trainingsstabilität verbessern und die Kreditzuweisung verbessern und es zu einer äußerst leistungsstarken Methode für das Verstärkungslernen in LLMs machen.

This reinforcement learning approach provides an efficient and scalable LLM training process with dense implicit process rewards. This eliminates step-level explicit annotations and minimizes training costs while enhancing sample efficiency, stability, and performance. The process combines online reward modeling and token-level feedback harmoniously, solving long-standing problems of reward sparsity and credit assignment in RL for LLMs. These improvements optimize reasoning capability in AI models and make them suitable for problem-solving applications in mathematics and programming. This research is a substantial contribution to RL-based L

Dieser Verstärkungslernenansatz bietet einen effizienten und skalierbaren LLM -Trainingsprozess mit dichten impliziten Prozessbelohnungen. Dies beseitigt explizite Anmerkungen auf Schrittebene und minimiert die Schulungskosten und verbessert gleichzeitig die Effizienz, Stabilität und Leistung von Stichproben. Der Prozess kombiniert harmonisch für Online-Belohnungsmodellierung und Token-Level-Feedback, wodurch langjährige Probleme der Belohnung und der Kreditaufgabe in RL für LLMs gelöst werden. Diese Verbesserungen optimieren die Argumentationsfähigkeit in KI-Modellen und machen sie für Problemlösungsanwendungen in Mathematik und Programmierung geeignet. Diese Forschung ist ein wesentlicher Beitrag zu RL-basierten L.

Haftungsausschluss:info@kdj.com

The information provided is not trading advice. kdj.com does not assume any responsibility for any investments made based on the information provided in this article. Cryptocurrencies are highly volatile and it is highly recommended that you invest with caution after thorough research!

If you believe that the content used on this website infringes your copyright, please contact us immediately (info@kdj.com) and we will delete it promptly.

-

-

- Panshibi ($ shibi) tritt als starke Alternative zu Shiba Inu (Shib) inmitten der Marktentwicklung auf

- Feb 08, 2025 at 06:41 pm

- Die Wirtschaftspolitik der Trump -Verwaltung wirkt sich derzeit auf etablierte Münzen wie Shiba Inu (SHIB) aus, was zu Kämpfen und zur Auswirkungen auf die Anlegerstimmung führt.

-

- Mooshot: Das aufstrebende Krypto-Projekt macht Wellen auf dem Markt

- Feb 08, 2025 at 06:41 pm

- Der Kryptomarkt mag volatil sein, aber das hat Mooshot nicht davon abgehalten, Wellen zu stellen. Das aufstrebende Krypto-Projekt hat bereits über 500.000 US-Dollar im Vorverkauf eingebracht, und die Dynamik zeigt keine Anzeichen einer Verlangsamung.

-

- Wir haben die KI gebeten, den Preis von Onyxcoin (XCN) vorherzusagen, wenn XRP 5 $ erreicht

- Feb 08, 2025 at 06:41 pm

- Eine weitere schwache Woche für Crypto steht kurz vor uns. Bitcoin konnte nicht 100.000 US -Dollar zurückerhalten, während alle Altcoins, einschließlich ETH und XRP, nicht bauen konnten

-

-

- Die strategische Investition von BlackRock in Strategie (ehemals MicroStrategy) hebt das wachsende Interesse an digitalen Vermögenswerten und Bitcoin hervor

- Feb 08, 2025 at 06:41 pm

- BlackRock, das weltweit größte Vermögensverwaltungsunternehmen, hat seinen Strategieanteil erheblich erhöht (früher als Microstrategy bekannt) und erhöhte seinen Besitz auf 5%

-

-

-

- Arctic Pablo Coin: Entfesselt das Abenteuer mit den besten neuen Meme -Münzen, in die man langfristig investieren kann

- Feb 08, 2025 at 06:31 pm

- Die Welt der Meme -Münzen wächst rasant, wobei fast jeden Tag neue Projekte auftauchen. Aber was eine Memmünze in einem so wettbewerbsfähigen Raum hervorstiftet