|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

G2PT: Graph Generative Pre-trained Transformer

Jan 06, 2025 at 04:21 am

Graph generation is a critical task in diverse fields like molecular design and social network analysis, owing to its capacity to model intricate relationships and structured data. Despite recent advances, many graph generative models heavily rely on adjacency matrix representations. While effective, these methods can be computationally demanding and often lack flexibility, making it challenging to efficiently capture the complex dependencies between nodes and edges, especially for large and sparse graphs. Current approaches, including diffusion-based and auto-regressive models, encounter difficulties in terms of scalability and accuracy, highlighting the need for more refined solutions.

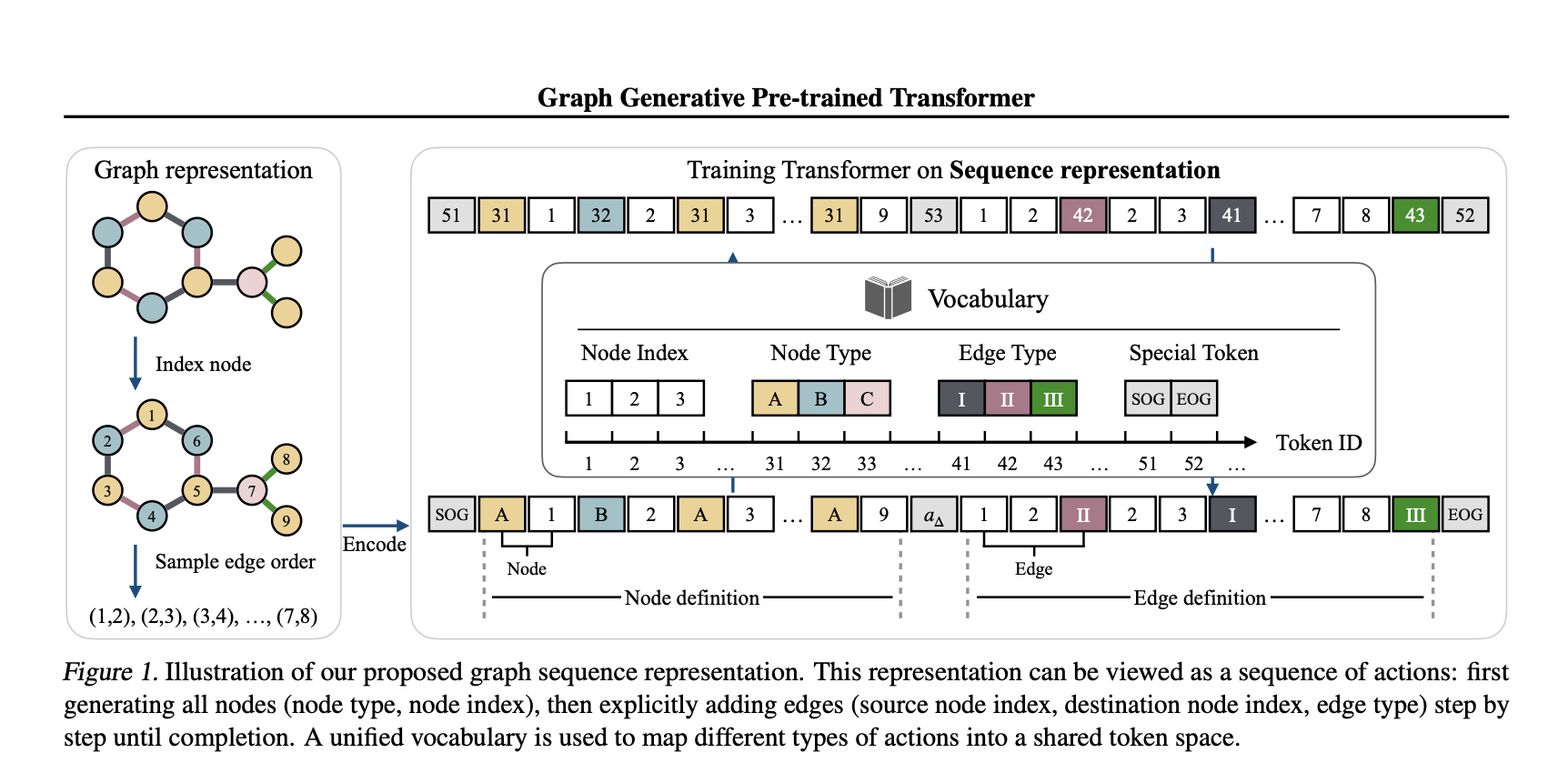

In a recent study, a team of researchers from Tufts University, Northeastern University, and Cornell University introduces the Graph Generative Pre-trained Transformer (G2PT), an auto-regressive model designed to learn graph structures through next-token prediction. Unlike traditional methods, G2PT employs a sequence-based representation of graphs, encoding nodes and edges as sequences of tokens. This approach streamlines the modeling process, making it more efficient and scalable. By leveraging a transformer decoder for token prediction, G2PT generates graphs that maintain structural integrity and flexibility. Moreover, G2PT can be readily adapted to downstream tasks, such as goal-oriented graph generation and graph property prediction, serving as a versatile tool for various applications.

Technical Insights and Benefits

G2PT introduces a novel sequence-based representation that decomposes graphs into node and edge definitions. Node definitions specify indices and types, whereas edge definitions outline connections and labels. This approach fundamentally differs from adjacency matrix representations, which focus on all possible edges, by considering only the existing edges, thereby reducing sparsity and computational complexity. The transformer decoder effectively models these sequences through next-token prediction, offering several advantages:

The researchers also explored fine-tuning methods for tasks like goal-oriented generation and graph property prediction, broadening the model’s applicability.

Experimental Results and Insights

G2PT has been evaluated on various datasets and tasks, demonstrating strong performance. In general graph generation, it matched or exceeded the state-of-the-art performance across seven datasets. In molecular graph generation, G2PT achieved high validity and uniqueness scores, reflecting its ability to accurately capture structural details. For instance, on the MOSES dataset, G2PTbase attained a validity score of 96.4% and a uniqueness score of 100%.

In a goal-oriented generation, G2PT aligned generated graphs with desired properties using fine-tuning techniques like rejection sampling and reinforcement learning. These methods enabled the model to adapt its outputs effectively. Similarly, in predictive tasks, G2PT’s embeddings delivered competitive results across molecular property benchmarks, reinforcing its suitability for both generative and predictive tasks.

Conclusion

The Graph Generative Pre-trained Transformer (G2PT) represents a thoughtful step forward in graph generation. By employing a sequence-based representation and transformer-based modeling, G2PT addresses many limitations of traditional approaches. Its combination of efficiency, scalability, and adaptability makes it a valuable resource for researchers and practitioners. While G2PT shows sensitivity to graph orderings, further exploration of universal and expressive edge-ordering mechanisms could enhance its robustness. G2PT exemplifies how innovative representations and modeling approaches can advance the field of graph generation.

Check out the Paper. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

🚨 FREE UPCOMING AI WEBINAR (JAN 15, 2025): Boost LLM Accuracy with Synthetic Data and Evaluation Intelligence–Join this webinar to gain actionable insights into boosting LLM model performance and accuracy while safeguarding data privacy.

Haftungsausschluss:info@kdj.com

Die bereitgestellten Informationen stellen keine Handelsberatung dar. kdj.com übernimmt keine Verantwortung für Investitionen, die auf der Grundlage der in diesem Artikel bereitgestellten Informationen getätigt werden. Kryptowährungen sind sehr volatil und es wird dringend empfohlen, nach gründlicher Recherche mit Vorsicht zu investieren!

Wenn Sie glauben, dass der auf dieser Website verwendete Inhalt Ihr Urheberrecht verletzt, kontaktieren Sie uns bitte umgehend (info@kdj.com) und wir werden ihn umgehend löschen.

-

-

- Dogecoin (DOGE) zeigt Anzeichen einer großen Rallye, die sie auf ein neues Allzeithoch treiben könnte

- Apr 26, 2025 at 02:40 pm

- DogEcoin, die MEME-basierte Kryptowährung, die Investoren und soziale Medien fasziniert hat, zeigt Anzeichen einer großen Rallye, die sie auf ein neues Allzeithoch treiben könnte.

-

- Pepe klettert, Wif Soars und BTFD könnten die beste Krypto sein, die im Jahr 2025 mit 200% ROI explodieren kann

- Apr 26, 2025 at 02:35 pm

- Meme -Münzen sind zurück - und sie sind wilder, lauter und mutiger als je zuvor. Einer steigt über eine halbe Milliarde Marktkapitalisierung, ein anderer fährt eine Milliarden-Dollar-Welle

-

- Dieser Ethereum -Händler verwandelte 250 US -Dollar in 20 Mio. USD auf Pepe. Jetzt zielen sie an eine andere froggy Meme -Münze

- Apr 26, 2025 at 02:35 pm

- Stellen Sie sich vor, Sie machen 250 US -Dollar in 20 Millionen US -Dollar, nicht durch Glück, sondern indem Sie früh auf den Frosch wetten, der die Blockchain schüttelte: Pepe.

-

- US -Präsidentessen Abendessen mit $ Trump Token Käufer ziehen Senatoren Wut an

- Apr 26, 2025 at 02:30 pm

- Die demokratischen Senatoren von Kalifornien und Massachusetts haben einen Brief an das US -amerikanische Staats -Ethik -Ethik über Trump gesendet, in dem er behauptete, der Präsident habe die Ethik verletzt, indem er den Menschen, die die Top -Trump -Münze mit Trump innehatten, eine bevorzugte Behandlung bei $ Trump -Münzinvestitionen gewährt habe.

-

-

-

-

- POL (ehemals matic) Preisvorhersage: Wird die Rallye fortgesetzt oder steht ein Rückzug unmittelbar bevor?

- Apr 26, 2025 at 02:20 pm

- Der Kryptowährungsmarkt hat eine turbulente Zeit, aber inmitten der vorsichtigen Rückgänge erregt ein Token die Aufmerksamkeit der Investoren: Pol (früher bekannt als Matic).

![Der Handel folgt, [Review Video] zu folgen, dass Gold Bitcoin -Rohölaufträge profitieren! Der Handel folgt, [Review Video] zu folgen, dass Gold Bitcoin -Rohölaufträge profitieren!](/uploads/2025/04/26/cryptocurrencies-news/videos/trading-follow-review-video-gold-bitcoin-crude-oil-profits/image-1.webp)