|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Carnegie Mellon University, NVIDIA, Shanghai Jiao Tong University 및 University of California Berkeley의 연구원들은 이러한 한계를 해결하기 위해 획기적인 구조 생성 엔진인 XGrammar를 개발했습니다.

As LLMs continue to advance, structured generation has become increasingly important. These models are now tasked with generating outputs that follow rigid formats, such as JSON, SQL, or other domain-specific languages. This capability is crucial for applications like code generation, robotic control, or structured querying. However, ensuring that outputs conform to specific structures without compromising speed or efficiency remains a significant challenge. While structured outputs enable seamless downstream processing, achieving these results requires innovative solutions due to the inherent complexity.

LLM이 계속해서 발전함에 따라 구조화된 생성이 점점 더 중요해지고 있습니다. 이제 이러한 모델은 JSON, SQL 또는 기타 도메인별 언어와 같은 엄격한 형식을 따르는 출력을 생성하는 작업을 담당합니다. 이 기능은 코드 생성, 로봇 제어 또는 구조적 쿼리와 같은 애플리케이션에 매우 중요합니다. 그러나 속도나 효율성을 저하시키지 않고 출력이 특정 구조에 부합하는지 확인하는 것은 여전히 중요한 과제로 남아 있습니다. 구조화된 출력을 통해 원활한 다운스트림 처리가 가능하지만 이러한 결과를 얻으려면 고유한 복잡성으로 인해 혁신적인 솔루션이 필요합니다.

Despite the recent advances in LLMs, there are still inefficiencies in structured output generation. One major challenge is handling the computational demands of adhering to grammatical constraints during output generation. Traditional methods, like context-free grammar (CFG) interpretation, require processing each possible token in the model’s vocabulary, which can exceed 128,000 tokens. Moreover, maintaining stack states to track recursive grammar rules adds to runtime delays. As a result, existing systems often experience high latency and increased resource usage, making them unsuitable for real-time or large-scale applications.

최근 LLM의 발전에도 불구하고 구조화된 결과 생성에는 여전히 비효율성이 있습니다. 한 가지 주요 과제는 출력 생성 중에 문법적 제약을 준수해야 하는 계산 요구 사항을 처리하는 것입니다. CFG(문맥 자유 문법) 해석과 같은 기존 방법에서는 모델 어휘에서 가능한 각 토큰을 처리해야 하며, 이는 128,000개 토큰을 초과할 수 있습니다. 게다가 재귀 문법 규칙을 추적하기 위해 스택 상태를 유지하면 런타임 지연이 추가됩니다. 결과적으로 기존 시스템은 대기 시간이 길고 리소스 사용량이 늘어나 실시간 또는 대규모 애플리케이션에 적합하지 않은 경우가 많습니다.

Current tools for structured generation utilize constrained decoding methods to ensure outputs align with predefined rules. These approaches filter out invalid tokens by setting their probabilities to zero at each decoding step. While effective, constrained decoding often needs to improve its efficiency due to evaluating each token against the entire stack state. Also, the recursive nature of CFGs further complicates these runtime processes. These challenges have limited the scalability and practicality of existing systems, particularly when handling complex structures or large vocabularies.

구조화된 생성을 위한 현재 도구는 제한된 디코딩 방법을 활용하여 출력이 사전 정의된 규칙과 일치하는지 확인합니다. 이러한 접근 방식은 각 디코딩 단계에서 확률을 0으로 설정하여 유효하지 않은 토큰을 필터링합니다. 제한된 디코딩은 효과적이기는 하지만 전체 스택 상태에 대해 각 토큰을 평가하므로 효율성을 향상시켜야 하는 경우가 많습니다. 또한 CFG의 재귀적 특성으로 인해 이러한 런타임 프로세스가 더욱 복잡해집니다. 이러한 과제로 인해 특히 복잡한 구조나 대규모 어휘를 처리할 때 기존 시스템의 확장성과 실용성이 제한되었습니다.

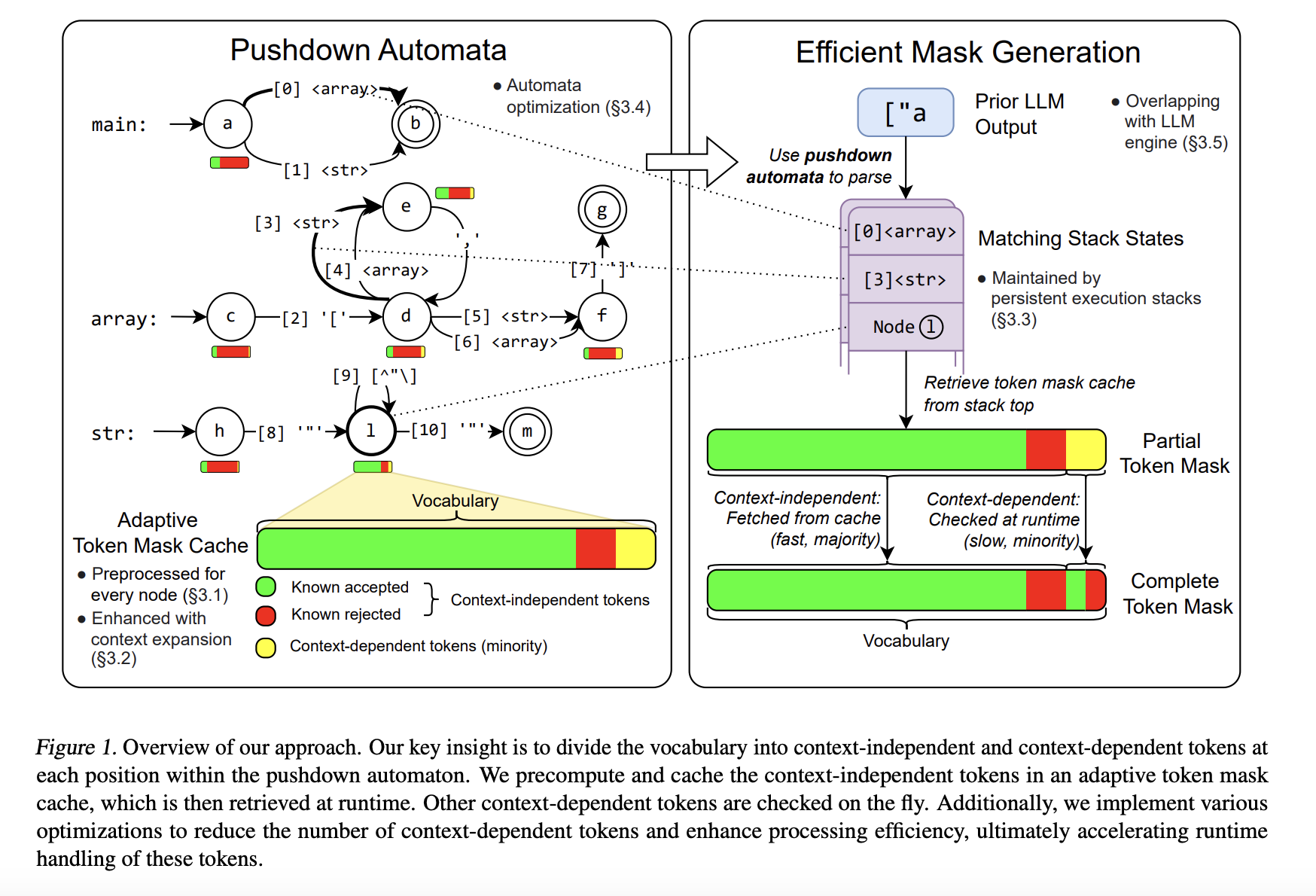

To address these limitations, researchers from Carnegie Mellon University, NVIDIA, Shanghai Jiao Tong University, and the University of California Berkeley developed XGrammar, a groundbreaking structured generation engine. XGrammar introduces a novel approach by dividing tokens into two categories: context-independent tokens that can be prevalidated and context-dependent tokens requiring runtime evaluation. This separation significantly reduces the computational burden during output generation. Also, the system incorporates a co-designed grammar and inference engine, enabling it to overlap grammar computations with GPU-based LLM operations, thereby minimizing overhead.

이러한 한계를 해결하기 위해 Carnegie Mellon University, NVIDIA, Shanghai Jiao Tong University 및 University of California Berkeley의 연구원들은 획기적인 구조화된 생성 엔진인 XGrammar를 개발했습니다. XGrammar는 토큰을 사전 검증이 가능한 컨텍스트 독립적 토큰과 런타임 평가가 필요한 컨텍스트 종속 토큰의 두 가지 범주로 나누어 새로운 접근 방식을 도입합니다. 이러한 분리는 출력 생성 중 계산 부담을 크게 줄여줍니다. 또한 시스템에는 공동 설계된 문법 및 추론 엔진이 통합되어 있어 문법 계산과 GPU 기반 LLM 작업을 중첩하여 오버헤드를 최소화할 수 있습니다.

XGrammar’s technical implementation includes several key innovations. It uses a byte-level pushdown automaton to process CFGs efficiently, enabling it to handle irregular token boundaries and nested structures. The adaptive token mask cache precomputes and stores validity for context-independent tokens, covering over 99% of tokens in most cases. Context-dependent tokens, representing less than 1% of the total, are processed using a persistent execution stack that allows for rapid branching and rollback operations. XGrammar’s preprocessing phase overlaps with the LLM’s initial prompt processing, ensuring near-zero latency for structured generation.

XGrammar의 기술 구현에는 몇 가지 주요 혁신이 포함됩니다. 바이트 수준 푸시다운 자동화 장치를 사용하여 CFG를 효율적으로 처리하므로 불규칙한 토큰 경계와 중첩 구조를 처리할 수 있습니다. 적응형 토큰 마스크 캐시는 대부분의 경우 토큰의 99% 이상을 포함하여 컨텍스트 독립적 토큰에 대한 유효성을 미리 계산하고 저장합니다. 전체의 1% 미만을 나타내는 컨텍스트 종속 토큰은 신속한 분기 및 롤백 작업을 허용하는 영구 실행 스택을 사용하여 처리됩니다. XGrammar의 전처리 단계는 LLM의 초기 프롬프트 처리와 겹치므로 구조화된 생성에 대해 거의 0에 가까운 대기 시간을 보장합니다.

Performance evaluations reveal the significant advantages of XGrammar. For JSON grammar tasks, the system achieves a token mask generation time of less than 40 microseconds, delivering up to a 100x speedup compared to traditional methods. Integrated with the Llama 3.1 model, XGrammar enables an 80x improvement in end-to-end structured output generation on the NVIDIA H100 GPU. Moreover, memory optimization techniques reduce storage requirements to just 0.2% of the original size, from 160 MB to 0.46 MB. These results demonstrate XGrammar’s ability to handle large-scale tasks with unprecedented efficiency.

성능 평가를 통해 XGrammar의 중요한 장점이 드러납니다. JSON 문법 작업의 경우 시스템은 40마이크로초 미만의 토큰 마스크 생성 시간을 달성하여 기존 방법에 비해 최대 100배의 속도 향상을 제공합니다. Llama 3.1 모델과 통합된 XGrammar는 NVIDIA H100 GPU에서 엔드투엔드 구조화된 출력 생성을 80배 향상시킵니다. 또한 메모리 최적화 기술은 스토리지 요구 사항을 원래 크기의 0.2%(160MB에서 0.46MB)로 줄입니다. 이러한 결과는 전례 없는 효율성으로 대규모 작업을 처리하는 XGrammar의 능력을 보여줍니다.

The researchers’ efforts have several key takeaways:

연구원들의 노력에는 몇 가지 주요 시사점이 있습니다.

In conclusion, XGrammar represents a transformative step in structured generation for large language models. Addressing inefficiencies in traditional CFG processing and constrained decoding offers a scalable, high-performance solution for generating structured outputs. Its innovative techniques, such as token categorization, memory optimization, and platform compatibility, make it an essential tool for advancing AI applications. With results up to 100x speedup and reduced latency, XGrammar sets a new standard for structured generation, enabling LLMs to meet modern AI systems’ demands effectively.

결론적으로 XGrammar는 대규모 언어 모델의 구조화된 생성에서 혁신적인 단계를 나타냅니다. 기존 CFG 처리 및 제한된 디코딩의 비효율성을 해결하면 구조화된 출력 생성을 위한 확장 가능한 고성능 솔루션이 제공됩니다. 토큰 분류, 메모리 최적화, 플랫폼 호환성과 같은 혁신적인 기술을 통해 AI 애플리케이션을 발전시키는 데 필수적인 도구가 되었습니다. 최대 100배의 속도 향상과 감소된 대기 시간을 통해 XGrammar는 구조화된 생성에 대한 새로운 표준을 설정하여 LLM이 최신 AI 시스템의 요구 사항을 효과적으로 충족할 수 있도록 합니다.

Check out the Paper and GitHub Page. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. If you like our work, you will love our newsletter.. Don’t Forget to join our 55k+ ML SubReddit.

Paper 및 GitHub 페이지를 확인하세요. 이 연구에 대한 모든 공로는 이 프로젝트의 연구자에게 돌아갑니다. 또한 Twitter에서 우리를 팔로우하고 Telegram 채널과 LinkedIn 그룹에 가입하는 것을 잊지 마세요. 저희 작업이 마음에 드셨다면 저희 뉴스레터도 마음에 드실 겁니다. 55,000개 이상의 ML SubReddit에 가입하는 것을 잊지 마세요.

[FREE AI VIRTUAL CONFERENCE] SmallCon: Free Virtual GenAI Conference ft. Meta, Mistral, Salesforce, Harvey AI & more. Join us on Dec 11th for this free virtual event to learn what it takes to build big with small models from AI trailblazers like Meta, Mistral AI, Salesforce, Harvey AI, Upstage, Nubank, Nvidia, Hugging Face, and more.

[무료 AI 가상 컨퍼런스] SmallCon: Meta, Mistral, Salesforce, Harvey AI 등의 무료 가상 GenAI 컨퍼런스. 12월 11일 무료 가상 이벤트에 참여하여 Meta, Mistral AI, Salesforce, Harvey AI, Upstage, Nubank, Nvidia, Hugging Face 등과 같은 AI 선구자의 작은 모델로 큰 규모를 구축하는 데 필요한 것이 무엇인지 알아보세요.

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.