|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

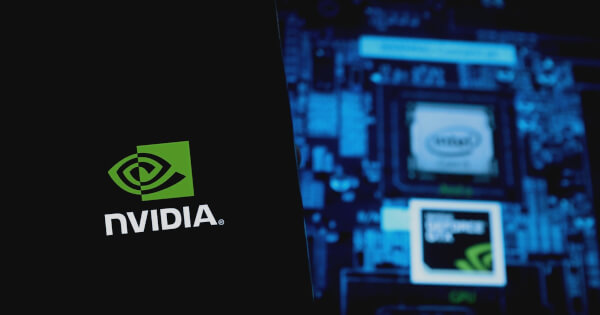

Alvin Lang 2024 年 8 月 27 日 02:52 NVIDIA は、日本と台湾で生成 AI をサポートする NIM マイクロサービスを開始し、地域言語モデルとローカル AI アプリケーションを強化します。

NVIDIA has introduced its NIM microservices for generative AI applications in Japan and Taiwan, aiming to bolster regional language models and support the development of本土化generative AI applications.

NVIDIA は、地域言語モデルを強化し、本土化生成 AI アプリケーションの開発をサポートすることを目的として、日本と台湾で生成 AI アプリケーション用の NIM マイクロサービスを導入しました。

Announced in an NVIDIA blog post on Saturday, the new microservices are designed to help developers build and deploy generative AI applications that are sensitive to local languages and cultural nuances. The microservices support popular community models, enhancing user interactions through improved understanding and responses based on regional languages and cultural heritage.

土曜日の NVIDIA ブログ投稿で発表されたこの新しいマイクロサービスは、開発者が現地の言語や文化的なニュアンスに敏感な生成 AI アプリケーションを構築および展開できるように設計されています。マイクロサービスは人気のあるコミュニティ モデルをサポートし、地域の言語や文化遺産に基づいた理解と応答の向上を通じてユーザー インタラクションを強化します。

According to ABI Research, generative AI software revenue in the Asia-Pacific region is projected to reach $48 billion by 2030, up from $5 billion in 2024. NVIDIA's new microservices are expected to play a significant role in this growth by providing advanced tools for AI development.

ABI Research によると、アジア太平洋地域における生成 AI ソフトウェアの収益は、2024 年の 50 億ドルから 2030 年までに 480 億ドルに達すると予測されています。NVIDIA の新しいマイクロサービスは、AI に高度なツールを提供することで、この成長に重要な役割を果たすことが期待されています発達。

Among the new offerings are the Llama-3-Swallow-70B and Llama-3-Taiwan-70B models, trained on Japanese and Mandarin data respectively. These models are designed to provide a deeper understanding of local laws, regulations, and customs.

新しい製品の中には、それぞれ日本語と中国語のデータでトレーニングされた Llama-3-Swallow-70B モデルと Llama-3-Taiwan-70B モデルがあります。これらのモデルは、現地の法律、規制、習慣をより深く理解できるように設計されています。

The RakutenAI 7B family of models, built on Mistral-7B, were trained on English and Japanese datasets and are available as NIM microservices for Chat and Instruct functionalities. These models achieved leading average scores among open Japanese large language models in the LM Evaluation Harness benchmark from January to March 2024.

Mistral-7B 上に構築されたRakutenAI 7B モデルファミリーは、英語と日本語のデータセットでトレーニングされており、チャットおよび指示機能用の NIM マイクロサービスとして利用できます。これらのモデルは、2024 年 1 月から 3 月までの LM 評価ハーネス ベンチマークにおいて、オープンな日本語大規模言語モデルの中でトップの平均スコアを達成しました。

Several organizations in Japan and Taiwan are already using NVIDIA's NIM microservices to develop and deploy generative AI applications.

日本と台湾のいくつかの組織は、すでに NVIDIA の NIM マイクロサービスを使用して生成 AI アプリケーションを開発および展開しています。

For instance, the Tokyo Institute of Technology has fine-tuned the Llama-3-Swallow 70B model using Japanese-language data. Preferred Networks, a Japanese AI company, is using the model to develop a healthcare-specific AI trained on Japanese medical data, achieving top scores on the Japan National Examination for Physicians.

たとえば、東京工業大学は、日本語データを使用して Llama-3-Swallow 70B モデルを微調整しました。日本の AI 企業である Preferred Networks は、このモデルを使用して日本の医療データに基づいてトレーニングされたヘルスケア特化型 AI を開発しており、日本の医師国家試験でトップスコアを獲得しています。

In Taiwan, Chang Gung Memorial Hospital is building a custom AI Inference Service to centrally host LLM applications within the hospital system, using the Llama-3-Taiwan 70B model to improve medical communication. Pegatron, a Taiwan-based electronics manufacturer, is adopting the model for both internal and external applications, integrating it with its PEGAAi Agentic AI System to boost efficiency in manufacturing and operations.

台湾の長庚記念病院は、Llama-3-Taiwan 70B モデルを使用して医療コミュニケーションを改善し、病院システム内で LLM アプリケーションを一元的にホストするカスタム AI 推論サービスを構築しています。台湾に本拠を置く電子機器メーカーである Pegatron は、社内および社外のアプリケーションの両方にこのモデルを採用し、PEGAAi Agentic AI システムと統合して製造と運用の効率を高めています。

Developers can now deploy these sovereign AI models, packaged as NIM microservices, into production at scale while achieving improved performance. The microservices, available with NVIDIA AI Enterprise, are optimized for inference with the NVIDIA TensorRT-LLM open-source library, providing up to 5x higher throughput and lowering the total cost of running the models in production.

開発者は、NIM マイクロサービスとしてパッケージ化されたこれらの主権 AI モデルを本番環境に大規模にデプロイしながら、パフォーマンスの向上を実現できるようになりました。 NVIDIA AI Enterprise で利用できるマイクロサービスは、NVIDIA TensorRT-LLM オープンソース ライブラリによる推論用に最適化されており、最大 5 倍の高いスループットを提供し、実稼働環境でのモデルの実行にかかる総コストを削減します。

The new NIM microservices are available today as hosted application programming interfaces (APIs).

新しい NIM マイクロサービスは、ホスト型アプリケーション プログラミング インターフェイス (API) として現在利用可能です。

To learn more about how NVIDIA NIM can accelerate generative AI outcomes, visit the product page here.

NVIDIA NIM が生成 AI の成果をどのように加速できるかについて詳しくは、こちらの製品ページをご覧ください。

Generative AI models, such as LLMs, have gained popularity for their ability to perform various tasks, including generating text, code, images, and videos. However, deploying these models can be challenging, especially for organizations that require fast and accurate results.

LLM などの生成 AI モデルは、テキスト、コード、画像、ビデオの生成など、さまざまなタスクを実行できる機能で人気を集めています。ただし、これらのモデルの導入は、特に迅速かつ正確な結果を必要とする組織にとっては困難な場合があります。

To address this need, NVIDIA offers a range of solutions, including the NVIDIA AI Enterprise software platform and the NVIDIA AI Registry, that provide security, performance optimization, and centralized management for generative AI models.

このニーズに対処するために、NVIDIA は、生成 AI モデルのセキュリティ、パフォーマンスの最適化、集中管理を提供する、NVIDIA AI Enterprise ソフトウェア プラットフォームや NVIDIA AI レジストリなどのさまざまなソリューションを提供しています。

With these solutions, organizations can deploy models quickly and efficiently, ensuring optimal performance and reliability for their applications.

これらのソリューションを使用すると、組織はモデルを迅速かつ効率的に展開し、アプリケーションの最適なパフォーマンスと信頼性を確保できます。

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。