|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

大規模な言語モデルは、人工知能の理解を大幅に進めてきましたが、これらのモデルを効率的にスケーリングすることは依然として困難です。

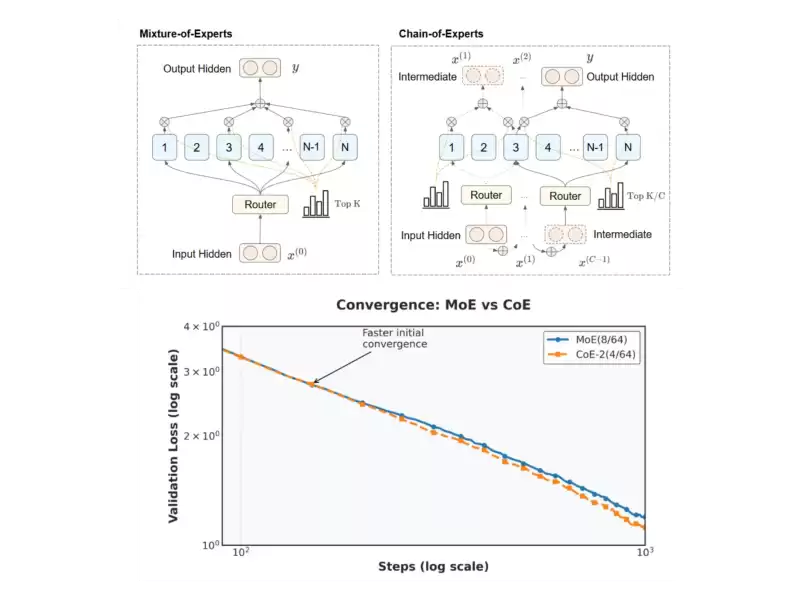

Large language models (LLMs) have revolutionized our understanding of artificial intelligence (AI), yet scaling these models efficiently remains a critical challenge. Traditional Mixture-of-Experts (MoE) architectures are designed to activate only a subset of experts per token in order to economize on computation. However, this design leads to two main issues. Firstly, experts process tokens in complete isolation—each expert performs its task without any cross-communication with others, which may limit the model’s ability to integrate diverse perspectives during processing. Secondly, although MoE models employ a sparse activation pattern, they still require considerable memory. This is because the overall parameter count is high, even if only a few experts are actively used at any given time. These observations suggest that while MoE models are a step forward in scalability, their inherent design may limit both performance and resource efficiency.

大規模な言語モデル(LLM)は、人工知能(AI)の理解に革命をもたらしましたが、これらのモデルを効率的にスケーリングすることは依然として重要な課題です。従来の専門家(MOE)のアーキテクチャは、計算を節約するために、トークンごとに専門家のサブセットのみを活性化するように設計されています。ただし、この設計は2つの主要な問題につながります。第一に、専門家はトークンを完全に孤立させて処理します。実際の専門家は、他の人と相互通信なしでタスクを実行します。これにより、処理中に多様な視点を統合するモデルの能力が制限される場合があります。第二に、MOEモデルはまばらな活性化パターンを採用していますが、依然としてかなりのメモリが必要です。これは、たとえ少数の専門家だけがいつでも積極的に使用されていても、全体的なパラメーター数が高いためです。これらの観察結果は、MOEモデルはスケーラビリティの一歩前進ですが、その固有の設計ではパフォーマンスとリソースの効率の両方を制限する可能性があることを示唆しています。

Chain-of-Experts (CoE)

チェーンオブエンパート(コー)

Chain-of-Experts (CoE) offers a fresh perspective on MoE architectures by introducing a mechanism for sequential communication among experts. Unlike the independent processing seen in traditional MoE models, CoE allows tokens to be processed in a series of iterations within each layer. In this arrangement, the output of one expert serves as the input for the next, creating a communicative chain that enables experts to build upon one another’s work. This sequential interaction does not simply stack layers; it facilitates a more integrated approach to token processing, where each expert refines the token’s meaning based on previous outputs. The goal is to use memory more efficiently.

Chain-of-Experts(COE)は、専門家間の連続コミュニケーションのメカニズムを導入することにより、MOEアーキテクチャに関する新鮮な視点を提供します。従来のMOEモデルで見られる独立した処理とは異なり、COEでは、各レイヤー内の一連の反復でトークンを処理できます。この配置では、1人の専門家の出力が次の専門家の入力として機能し、専門家が互いの仕事に基づいて構築できるコミュニケーションチェーンを作成します。このシーケンシャルな相互作用は、単にレイヤーをスタックするわけではありません。トークン処理に対するより統合されたアプローチを促進します。各エキスパートは、以前の出力に基づいてトークンの意味を改良します。目標は、メモリをより効率的に使用することです。

Technical Details and Benefits

技術的な詳細と利点

At the heart of the CoE method is an iterative process that redefines how experts interact. For instance, consider a configuration described as CoE-2(4/64): the model operates with two iterations per token, with four experts selected from a pool of 64 at each cycle. This contrasts with traditional MoE, which uses a single pass through a pre-selected group of experts.

COEメソッドの中心にあるのは、専門家がどのように相互作用するかを再定義する反復プロセスです。たとえば、COE-2(4/64)として説明されている構成を検討してください。モデルは、トークンごとに2回の反復で動作し、各サイクルで64人のプールから4人の専門家が選択されます。これは、事前に選択された専門家グループを単一のパスを使用する従来のMOEとは対照的です。

Another key technical element in CoE is the independent gating mechanism. In conventional MoE models, the gating function decides which experts should process a token, and these decisions are made once per token per layer. However, CoE takes this a step further by allowing each expert’s gating decision to be made independently during each iteration. This flexibility encourages a form of specialization, as an expert can adjust its processing based on the information received from earlier iterations.

COEのもう1つの重要な技術的要素は、独立したゲーティングメカニズムです。従来のMOEモデルでは、ゲーティング機能は、どの専門家がトークンを処理するかを決定し、これらの決定はレイヤーごとにトークンごとに1回行われます。ただし、COEは、各反復中に各専門家のゲーティングの決定を個別に行うことを可能にすることにより、これをさらに一歩進めます。この柔軟性は、専門家が以前の反復から受け取った情報に基づいて処理を調整できるため、専門化の一種を促進します。

Furthermore, the use of inner residual connections in CoE enhances the model. Instead of simply adding the original token back after the entire sequence of processing (an outer residual connection), CoE integrates residual connections within each iteration. This design helps to maintain the integrity of the token’s information while allowing for incremental improvements at every step.

さらに、COEで内部残留接続を使用すると、モデルが強化されます。 COEは、処理のシーケンス全体(外側の残留接続)の後に元のトークンを単に追加する代わりに、各反復内に残留接続を統合します。この設計は、トークンの情報の完全性を維持しながら、あらゆるステップで漸進的な改善を可能にするのに役立ちます。

These technical innovations combine to create a model that aims to retain performance with fewer resources and provides a more nuanced processing pathway, which could be valuable for tasks requiring layered reasoning.

これらの技術的な革新は、より少ないリソースでパフォーマンスを維持し、より微妙な処理経路を提供することを目的とするモデルを作成し、レイヤード推論を必要とするタスクにとって価値がある可能性があります。

Experimental Results and Insights

実験結果と洞察

Preliminary experiments, such as pretraining on math-related tasks, show promise for the Chain-of-Experts method. In a configuration denoted as CoE-2(4/64), two iterations of four experts from a pool of 64 were used in each layer. Compared with traditional MoE operating under the same computational constraints, CoE-2(4/64) achieved a lower validation loss (1.12 vs. 1.20) without any increase in memory or computational cost.

数学関連のタスクでの事前供与などの予備的な実験は、Expertsのチェーン法の可能性を示しています。 COE-2(4/64)として示された構成では、64人のプールから4人の専門家の2つの反復が各層で使用されました。同じ計算上の制約の下で動作している従来のMOEと比較して、COE-2(4/64)は、メモリや計算コストを上げることなく、より低い検証損失(1.12対1.20)を達成しました。

The researchers also varied the configurations of Chain-of-Experts and compared them with traditional Mixture-of-Experts (MoE) models. For example, they tested CoE-2(4/64), CoE-1(8/64), and MoE(8) models, all operating within similar computational and memory footprints. Their findings showed that increasing the iteration count in Chain-of-Experts yielded benefits comparable to or even better than increasing the number of experts selected in a single pass. Even when the models were deployed on the same hardware and subjected to the same computational constraints, Chain-of-Experts demonstrated an advantage in terms of both performance and resource utilization.

研究者はまた、専門家の連鎖の構成を変化させ、それらを従来の混合物(MOE)モデルと比較しました。たとえば、彼らはCOE-2(4/64)、COE-1(8/64)、およびMOE(8)モデルをテストし、すべて同様の計算およびメモリフットプリント内で動作しました。彼らの発見は、専門家のチェーンの反復数を増やすと、単一のパスで選択された専門家の数を増やすよりも、またはそれ以上の利益が得られることを示しました。モデルが同じハードウェアに展開され、同じ計算上の制約にさらされた場合でも、エクスペルのチェーンは、パフォーマンスとリソースの利用の両方の点で利点を示しました。

In one experiment, a single layer of MoE with eight experts was compared with two layers of Chain-of-Experts, each selecting four experts. Despite having fewer experts in each layer, Chain-of-Experts achieved better performance. Moreover, when varying the experts' capacity (output dimension) while keeping the total parameters constant, Chain-of-Experts configurations showed up to an 18% reduction in memory usage while realizing similar or slightly better performance.

ある実験では、8人の専門家を持つMOEの単一層を、それぞれ4人の専門家を選択している2層の専門家と比較されました。各レイヤーの専門家が少ないにもかかわらず、エンパーのチェーンはより良いパフォーマンスを達成しました。さらに、総パラメーターを一定に保ちながら専門家の容量(出力寸法)を変化させると、同様のパフォーマンスまたはわずかに優れたパフォーマンスを実現しながら、メモリ使用量が18%減少していることが示されました。

Another key finding was the dramatic increase in the number of possible expert combinations. With two iterations of four experts from a pool of 64, there were 3.8 x 10¹⁰⁴ different expert combinations in a single layer of Chain-of-Experts. In contrast, a single layer of MoE with eight experts had only 2.2 x 10⁴² combinations

もう1つの重要な発見は、可能な専門家の組み合わせの数の劇的な増加でした。 64人のプールからの4人の専門家の2つの反復により、単一層の専門家の層に3.8 x10¹⁰⁴の組み合わせがありました。対照的に、8人の専門家を持つMOEの単一層には、2.2 x 10〜²の組み合わせしかありませんでした

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。