|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

Blackwell Ultra de Nvidia et CPU Vera et Rubin à venir

Mar 24, 2025 at 01:38 am

Par Michael D. Kats

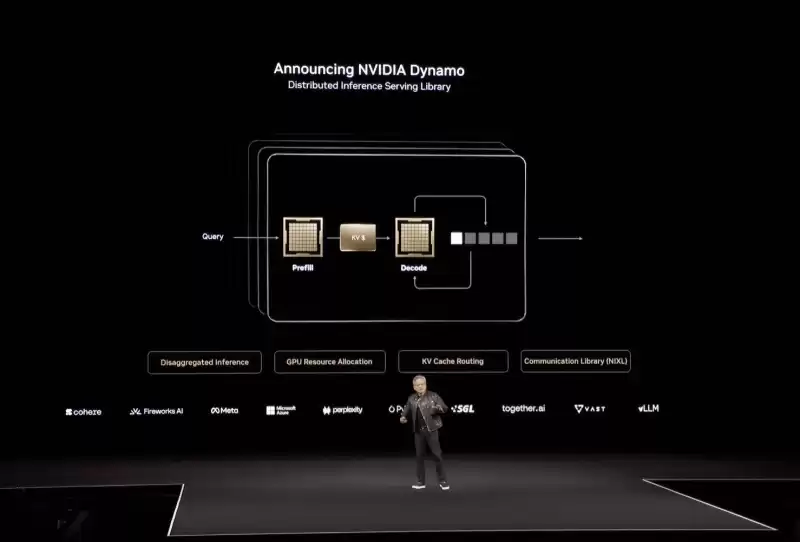

Nvidia's gargantuan Blackwell Ultra and upcoming Vera and Rubin CPUs and GPUs have certainly grabbed plenty of headlines at the corp's GPU Technology Conference this week. But arguably one of the most important announcements of the annual developer event wasn't a chip at all but rather a software framework called Dynamo, designed to tackle the challenges of AI inference at scale.

Les Blackwell Ultra de Nvidia Blackwell Ultra et les CPU et GPU Vera et Rubin à venir ont certainement fait la une des journaux lors de la conférence sur la technologie GPU du Corp cette semaine. Mais sans doute l'une des annonces les plus importantes de l'événement de développeur annuel n'était pas du tout une puce, mais plutôt un cadre logiciel appelé Dynamo, conçu pour relever les défis de l'inférence de l'IA à grande échelle.

Announced on stage at GTC, it was described by CEO Jensen Huang as the "operating system of an AI factory," and drew comparisons to the real-world dynamo that kicked off an industrial revolution. "The dynamo was the first instrument that started the last industrial revolution," the chief exec said. "The industrial revolution of energy — water comes in, electricity comes out."

Annoncé sur scène de la GTC, il a été décrit par le PDG Jensen Huang comme le «système d'exploitation d'une usine d'IA» et a fait des comparaisons avec la dynamo réel qui a lancé une révolution industrielle. "Le Dynamo a été le premier instrument qui a commencé la dernière révolution industrielle", a déclaré le chef. "La révolution industrielle de l'énergie - l'eau entre, l'électricité sort."

At its heart, the open source inference suite is designed to better optimize inference engines such as TensorRT LLM, SGLang, and vLLM to run across large quantities of GPUs as quickly and efficiently as possible.

En son cœur, l'Open Source Inference Suite est conçue pour mieux optimiser les moteurs d'inférence tels que Tensorrt LLM, SGLANG et VLLM pour traverser de grandes quantités de GPU aussi rapidement et efficacement que possible.

As we've previously discussed, the faster and cheaper you can turn out token after token from a model, the better the experience for users.

Comme nous l'avons discuté précédemment, plus vous pouvez vous avancer de jeton plus rapide et moins cher, meilleur est l'expérience pour les utilisateurs.

Inference is harder than it looks

L'inférence est plus difficile qu'il n'y paraît

At a high level, LLM output performance can be broken into two broad categories: Prefill and decode. Prefill is dictated by how quickly the GPU's floating-point matrix math accelerators can process the input prompt. The longer the prompt — say, a summarization task — the longer this typically takes.

À un niveau élevé, les performances de sortie LLM peuvent être divisées en deux grandes catégories: le pré-rempli et le décodage. Le préfusion est dicté par la rapidité avec laquelle les accélérateurs matriciels de matrice à virgule flottante du GPU peuvent traiter l'invite d'entrée. Plus l'invite - disons, une tâche de résumé - plus cela prend généralement longtemps.

Decode, on the other hand, is what most people associate with LLM performance, and equates to how quickly the GPUs can produce the actual tokens as a response to the user's prompt.

Decode, en revanche, est ce que la plupart des gens associent aux performances de LLM, et équivaut à la rapidité avec laquelle les GPU peuvent produire les jetons réels en réponse à l'invite de l'utilisateur.

So long as your GPU has enough memory to fit the model, decode performance is usually a function of how fast that memory is and how many tokens you're generating. A GPU with 8TB/s of memory bandwidth will churn out tokens more than twice as fast as one with 3.35TB/s.

Tant que votre GPU a suffisamment de mémoire pour s'adapter au modèle, les performances de décodeur sont généralement en fonction de la vitesse à laquelle cette mémoire est et du nombre de jetons que vous générez. Un GPU avec 8 To / s de bande passante de mémoire provoquera des jetons plus de deux fois plus rapidement que celui de 3,35 To / s.

Where things start to get complicated is when you start looking at serving up larger models to more people with longer input and output sequences, like you might see in an AI research assistant or reasoning model.

Là où les choses commencent à se compliquer, c'est lorsque vous commencez à chercher des modèles plus grands à plus de personnes avec des séquences d'entrée et de sortie plus longues, comme vous pourriez le voir dans un assistant de recherche sur l'IA ou un modèle de raisonnement.

Large models are typically distributed across multiple GPUs, and the way this is accomplished can have a major impact on performance and throughput, something Huang discussed at length during his keynote.

Les grands modèles sont généralement répartis sur plusieurs GPU, et la façon dont cela est accompli peut avoir un impact majeur sur les performances et le débit, ce que Huang a discuté longuement pendant son discours.

"Under the Pareto frontier are millions of points we could have configured the datacenter to do. We could have parallelized and split the work and sharded the work in a whole lot of different ways," he said.

"Dans le cadre de la frontière de Pareto se trouvent des millions de points, nous aurions pu configurer le centre de données. Nous aurions pu paralléliser et diviser le travail et a-t-il enraciné le travail de différentes manières", a-t-il déclaré.

What he means is, depending on your model's parallelism you might be able to serve millions of concurrent users but only at 10 tokens a second each. Meanwhile another combination is only be able to serve a few thousand concurrent requests but generate hundreds of tokens in the blink of an eye.

Ce qu'il veut dire, c'est que, selon le parallélisme de votre modèle, vous pourriez être en mesure de servir des millions d'utilisateurs simultanés, mais seulement à 10 jetons par seconde chacun. Pendant ce temps, une autre combinaison n'est en mesure de ne servir que quelques milliers de demandes simultanées mais générer des centaines de jetons en un clin d'œil.

According to Huang, if you can figure out where on this curve your workload delivers the ideal mix of individual performance while also achieving the maximum throughput possible, you'll be able to charge a premium for your service and also drive down operating costs. We imagine this is the balancing act at least some LLM providers perform when scaling up their generative applications and services to more and more customers.

Selon Huang, si vous pouvez déterminer où sur cette courbe, votre charge de travail offre le mélange idéal de performances individuelles tout en réalisant le débit maximal possible, vous pourrez facturer une prime pour votre service et également réduire les coûts d'exploitation. Nous imaginons qu'il s'agit de l'équilibrage au moins certains fournisseurs de LLM fonctionnent lors de la mise à l'échelle de leurs applications et services génératifs à de plus en plus de clients.

Cranking the Dynamo

Genant la dynamo

Finding this happy medium between performance and throughput is one the key capabilities offered by Dynamo, we're told.

Trouver ce juste milieu entre la performance et le débit est l'une des capacités clés offertes par Dynamo, nous dit-on.

In addition to providing users with insights as to what the ideal mix of expert, pipeline, or tensor parallelism might be, Dynamo disaggregates prefill and decode onto different accelerators.

En plus de fournir aux utilisateurs des informations sur le mélange idéal de parallélisme expert, pipeline ou tensor, Dynamo désagrége le pré-rempli et le décodage sur différents accélérateurs.

According to Nvidia, a GPU planner within Dynamo determines how many accelerators should be dedicated to prefill and decode based on demand.

Selon NVIDIA, un planificateur de GPU au sein de Dynamo détermine le nombre d'accélérateurs qui devraient être dédiés au préfagiteur et au décodage en fonction de la demande.

However, Dynamo isn't just a GPU profiler. The framework also includes prompt routing functionality, which identifies and directs overlapping requests to specific groups of GPUs to maximize the likelihood of a key-value (KV) cache hit.

Cependant, Dynamo n'est pas seulement un profileur GPU. Le cadre comprend également une fonctionnalité de routage rapide, qui identifie et dirige les demandes de chevauchement vers des groupes spécifiques de GPU pour maximiser la probabilité d'un hit de cache de valeur clé (KV).

If you're not familiar, the KV cache represents the state of the model at any given time. So, if multiple users ask similar questions in short order, the model can pull from this cache rather than recalculating the model state over and over again.

Si vous n'êtes pas familier, le cache KV représente l'état du modèle à tout moment. Ainsi, si plusieurs utilisateurs posent des questions similaires en peu de temps, le modèle peut retirer de ce cache plutôt que de recalculer l'état du modèle encore et encore.

Alongside the smart router, Dynamo also features a low-latency communication library to speed up GPU-to-GPU data flows, and a memory management subsystem that's responsible for pushing or pulling KV cache data from HBM to or from system memory or cold storage to maximize responsiveness and minimize wait times.

Parallèlement au routeur intelligent, Dynamo propose également une bibliothèque de communication à faible latence pour accélérer les flux de données GPU-GPU, et un sous-système de gestion de la mémoire responsable de la poussée ou de la réduction des données de cache KV de HBM vers ou depuis la mémoire du système ou le stockage froid pour maximiser la réactivité et minimiser les temps d'attente.

For Hopper-based systems running Llama models, Nvidia claims Dynamo can effectively double the inference performance. Meanwhile for larger Blackwell NVL72 systems, the GPU giant claims a 30x advantage in DeepSeek-R1 over Hopper with the framework enabled.

Pour les systèmes basés sur la trémie exécutant des modèles LLAMA, NVIDIA affirme que Dynamo peut doubler les performances d'inférence. Pendant ce temps, pour les plus grands systèmes Blackwell NVL72, le géant du GPU revendique un avantage de 30x dans Deepseek-R1 sur Hopper avec le cadre activé.

Broad compatibility

Compatibilité large

While Dynamo is obviously tuned for Nvidia's hardware and software stacks, much like the Triton Inference Server it replaces, the framework is designed to integrate with popular software libraries for model serving, like vLLM, PyTorch, and SGLang.

Bien que Dynamo soit évidemment réglé pour les piles matérielles et logicielles de NVIDIA, tout comme le serveur d'inférence Triton qu'il remplace, le framework est conçu pour s'intégrer aux bibliothèques de logiciels populaires pour le service de modèle, comme VLLM, Pytorch et SGLANG.

This means, if you

Cela signifie, si vous

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

- 5 signaux de divergence indiquent un rallye de prix Bitcoin et une reprise altcoin au second semestre avril 2025

- Apr 24, 2025 at 07:20 pm

- La divergence est un concept clé de l'analyse des données. Cela se produit lorsque les valeurs de deux mesures se déplacent soudainement et se déplacent dans des directions opposées

-

-

-

-

- Shiba INU (SCH) Prédiction des prix: les indicateurs techniques suggèrent une surtension potentielle

- Apr 24, 2025 at 07:10 pm

- Les observateurs du marché ont tourné leur attention vers Shiba INU car les indicateurs techniques suggèrent une augmentation de prix potentielle de la populaire pièce de mèmes.

-

-

-

-

- Les propriétaires de chiens doivent être conscients des dangers des graines de gazon et de la façon dont ils peuvent être dangereux pour les chiens.

- Apr 24, 2025 at 07:00 pm

- Alors que les graines de gazon peuvent sembler petites et inoffensives, le vétérinaire PDSA prévient qu'ils peuvent nuire à nos amis à quatre pattes.