|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

Nvidias Blackwell Ultra und bevorstehende Vera und Rubin CPUs und GPUs

Mar 24, 2025 at 01:38 am

Von Michael D. Kats

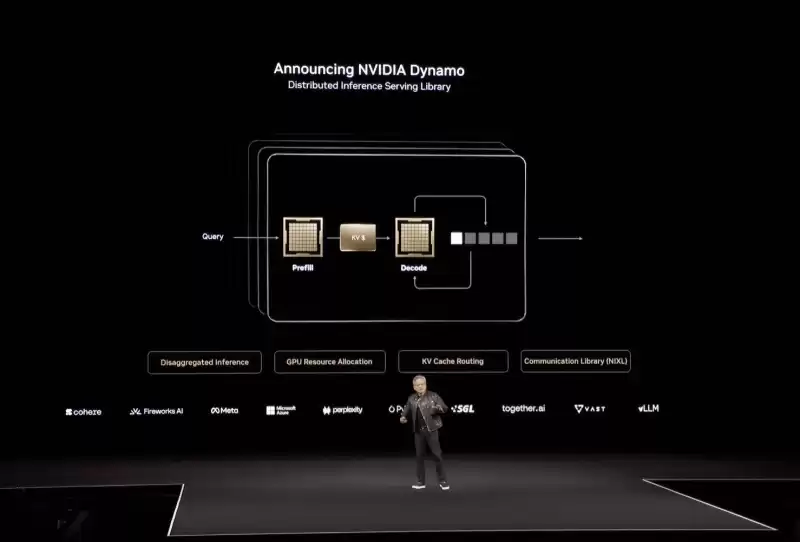

Nvidia's gargantuan Blackwell Ultra and upcoming Vera and Rubin CPUs and GPUs have certainly grabbed plenty of headlines at the corp's GPU Technology Conference this week. But arguably one of the most important announcements of the annual developer event wasn't a chip at all but rather a software framework called Dynamo, designed to tackle the challenges of AI inference at scale.

Nvidias gargantuaner Blackwell Ultra sowie die kommenden Vera und Rubin CPUs und GPUs haben diese Woche auf der GPU -Technologiekonferenz der Corpu -Technologie viele Schlagzeilen gemacht. Aber wohl eine der wichtigsten Ankündigungen des jährlichen Entwicklerereignisses war überhaupt kein Chip, sondern eher ein Software -Framework namens Dynamo, der die Herausforderungen der KI -Inferenz in der Skala bewältigen soll.

Announced on stage at GTC, it was described by CEO Jensen Huang as the "operating system of an AI factory," and drew comparisons to the real-world dynamo that kicked off an industrial revolution. "The dynamo was the first instrument that started the last industrial revolution," the chief exec said. "The industrial revolution of energy — water comes in, electricity comes out."

Auf der Bühne bei GTC wurde es von CEO Jensen Huang als "Betriebssystem einer AI-Fabrik" beschrieben und vergleiche mit dem realen Dynamo, der eine industrielle Revolution begann. "Der Dynamo war das erste Instrument, das die letzte industrielle Revolution begann", sagte der Chief Exec. "Die industrielle Revolution der Energie - Wasser kommt herein, Strom kommt heraus."

At its heart, the open source inference suite is designed to better optimize inference engines such as TensorRT LLM, SGLang, and vLLM to run across large quantities of GPUs as quickly and efficiently as possible.

Im Herzen ist die Open -Source -Inferenz -Suite entwickelt, um Inferenzmotoren wie Tensorrt LLM, Sglang und VLLM besser zu optimieren, um so schnell und effizient wie möglich über große Mengen von GPUs zu laufen.

As we've previously discussed, the faster and cheaper you can turn out token after token from a model, the better the experience for users.

Wie wir bereits diskutiert haben, können Sie nach dem Token von einem Modell umso schneller und billiger werden, desto besser ist die Erfahrung für Benutzer.

Inference is harder than it looks

Inferenz ist schwieriger als es aussieht

At a high level, LLM output performance can be broken into two broad categories: Prefill and decode. Prefill is dictated by how quickly the GPU's floating-point matrix math accelerators can process the input prompt. The longer the prompt — say, a summarization task — the longer this typically takes.

Auf einem hohen Niveau kann die LLM -Ausgangsleistung in zwei breite Kategorien unterteilt werden: Vorab- und Dekodieren. Vorab wird diktiert, wie schnell die Mathematikbeschleuniger der GPU die Eingabeaufforderung verarbeiten können. Je länger die Eingabeaufforderung - beispielsweise eine Zusammenfassung -, desto länger dauert dies normalerweise.

Decode, on the other hand, is what most people associate with LLM performance, and equates to how quickly the GPUs can produce the actual tokens as a response to the user's prompt.

Decodieren hingegen ist das, was die meisten Menschen mit der LLM -Leistung verbinden, und entspricht, wie schnell der GPUs die tatsächlichen Token als Antwort auf die Eingabeaufforderung des Benutzers erzeugen können.

So long as your GPU has enough memory to fit the model, decode performance is usually a function of how fast that memory is and how many tokens you're generating. A GPU with 8TB/s of memory bandwidth will churn out tokens more than twice as fast as one with 3.35TB/s.

Solange Ihre GPU über genügend Speicher verfügt, um das Modell anzupassen, ist die Dekodierungsleistung normalerweise davon ab, wie schnell dieser Speicher ist und wie viele Token Sie generieren. Eine GPU mit 8 TB/s Speicherbandbreite wird mehr als doppelt so schnell wie eine mit 3,35 TB/s ausgewachsen.

Where things start to get complicated is when you start looking at serving up larger models to more people with longer input and output sequences, like you might see in an AI research assistant or reasoning model.

Wo die Dinge kompliziert werden, ist, wenn Sie anfangen, größere Modelle für mehr Menschen mit längeren Eingabe- und Ausgabemerkundungssequenzen zu bedienen, wie Sie vielleicht in einem KI -Forschungsassistenten oder Argumentationsmodell sehen.

Large models are typically distributed across multiple GPUs, and the way this is accomplished can have a major impact on performance and throughput, something Huang discussed at length during his keynote.

Große Modelle sind in der Regel über mehrere GPUs verteilt, und die Art und Weise, wie dies erreicht wird, kann einen großen Einfluss auf die Leistung und den Durchsatz haben, was Huang während seiner Keynote ausführlich besprochen hat.

"Under the Pareto frontier are millions of points we could have configured the datacenter to do. We could have parallelized and split the work and sharded the work in a whole lot of different ways," he said.

"Unter der Pareto -Grenze haben wir Millionen von Punkten, für die wir das DataCenter hätten konfigurieren können.

What he means is, depending on your model's parallelism you might be able to serve millions of concurrent users but only at 10 tokens a second each. Meanwhile another combination is only be able to serve a few thousand concurrent requests but generate hundreds of tokens in the blink of an eye.

Was er meint, ist, dass Sie je nach Parallelität Ihres Modells Millionen von gleichzeitigen Benutzern bedienen können, jedoch nur bei 10 Token pro Sekunde. In der Zwischenzeit kann eine andere Kombination nur ein paar tausend gleichzeitige Anfragen dienen, sondern im Handumdrehen Hunderte von Token erzeugen.

According to Huang, if you can figure out where on this curve your workload delivers the ideal mix of individual performance while also achieving the maximum throughput possible, you'll be able to charge a premium for your service and also drive down operating costs. We imagine this is the balancing act at least some LLM providers perform when scaling up their generative applications and services to more and more customers.

Laut Huang können Sie herausfinden, wo Ihre Arbeitsbelastung auf dieser Kurve die ideale Mischung aus individueller Leistung liefert und gleichzeitig den maximalen Durchsatz erzielt, eine Prämie für Ihren Service und die Betriebskosten senken. Wir stellen uns vor, dies ist der Balancegesetz, zumindest einige LLM -Anbieter, wenn sie ihre generativen Anwendungen und Dienstleistungen für immer mehr Kunden skalieren.

Cranking the Dynamo

Den Dynamo anregen

Finding this happy medium between performance and throughput is one the key capabilities offered by Dynamo, we're told.

Das Finden dieses glücklichen Mediums zwischen Leistung und Durchsatz ist eine der wichtigsten Funktionen, die Dynamo angeboten haben.

In addition to providing users with insights as to what the ideal mix of expert, pipeline, or tensor parallelism might be, Dynamo disaggregates prefill and decode onto different accelerators.

Dynamo disaggregiert nicht nur Einblicke in die ideale Mischung aus Experten, Pipeline oder Tensor -Parallelität, sondern auch die Vorauszahlungen und dekodieren sie auf verschiedene Beschleuniger.

According to Nvidia, a GPU planner within Dynamo determines how many accelerators should be dedicated to prefill and decode based on demand.

Laut NVIDIA stellt ein GPU -Planer innerhalb von Dynamo fest, wie viele Beschleuniger auf der Grundlage der Nachfrage eingesetzt werden sollten.

However, Dynamo isn't just a GPU profiler. The framework also includes prompt routing functionality, which identifies and directs overlapping requests to specific groups of GPUs to maximize the likelihood of a key-value (KV) cache hit.

Dynamo ist jedoch nicht nur ein GPU -Profiler. Das Framework enthält auch eine schnelle Routing-Funktionalität, die überlappende Anforderungen an bestimmte GPU-Gruppen identifiziert und leitet, um die Wahrscheinlichkeit eines KV-Cache-Titels (Schlüsselwerte) zu maximieren.

If you're not familiar, the KV cache represents the state of the model at any given time. So, if multiple users ask similar questions in short order, the model can pull from this cache rather than recalculating the model state over and over again.

Wenn Sie nicht vertraut sind, repräsentiert der KV -Cache zu einem bestimmten Zeitpunkt den Status des Modells. Wenn also mehrere Benutzer in kurzer Zeit ähnliche Fragen stellen, kann das Modell diesen Cache anstatt den Modellzustand immer wieder neu zu berechnen.

Alongside the smart router, Dynamo also features a low-latency communication library to speed up GPU-to-GPU data flows, and a memory management subsystem that's responsible for pushing or pulling KV cache data from HBM to or from system memory or cold storage to maximize responsiveness and minimize wait times.

Neben dem Smart-Router verfügt Dynamo auch über eine Kommunikationsbibliothek mit niedriger Latenz, um die GPU-to-GPU-Datenflüsse zu beschleunigen, und ein Speicherverwaltungs-Subsystem, das für das Schieben oder Abziehen von KV-Cache-Daten von HBM zu oder aus dem Systemspeicher oder aus dem Systemspeicher verantwortlich ist, um die Reaktionsfähigkeit zu maximieren und die Wartezeiten zu minimieren.

For Hopper-based systems running Llama models, Nvidia claims Dynamo can effectively double the inference performance. Meanwhile for larger Blackwell NVL72 systems, the GPU giant claims a 30x advantage in DeepSeek-R1 over Hopper with the framework enabled.

Für Hopper-basierte Systeme, die Lama-Modelle ausführen, kann Nvidia behauptet, Dynamo kann die Inferenzleistung effektiv verdoppeln. In der Zwischenzeit für größere Blackwell NVL72-Systeme behauptet der GPU-Riese einen 30-fachen Vorteil in Deepseek-R1 gegenüber Hopper mit dem aktivierten Framework.

Broad compatibility

Breite Kompatibilität

While Dynamo is obviously tuned for Nvidia's hardware and software stacks, much like the Triton Inference Server it replaces, the framework is designed to integrate with popular software libraries for model serving, like vLLM, PyTorch, and SGLang.

Während Dynamo offensichtlich auf die Hardware- und Software -Stapel von NVIDIA abgestimmt ist, ist das Framework wie der von Triton Inference Server ersetzt, aber das Framework ist so konzipiert, dass sie sich in beliebte Software -Bibliotheken für Modelldienste wie VllM, Pytorch und Sglang integrieren.

This means, if you

Das heißt, wenn Sie

Haftungsausschluss:info@kdj.com

Die bereitgestellten Informationen stellen keine Handelsberatung dar. kdj.com übernimmt keine Verantwortung für Investitionen, die auf der Grundlage der in diesem Artikel bereitgestellten Informationen getätigt werden. Kryptowährungen sind sehr volatil und es wird dringend empfohlen, nach gründlicher Recherche mit Vorsicht zu investieren!

Wenn Sie glauben, dass der auf dieser Website verwendete Inhalt Ihr Urheberrecht verletzt, kontaktieren Sie uns bitte umgehend (info@kdj.com) und wir werden ihn umgehend löschen.

-

- Die PayPal-Coinbase-Partnerschaft verleiht Stablecoins die Glaubwürdigkeit von Unternehmen durch Handel mit Null-Fee-Handel, garantierte Rückzahlung und Mainstream-Verteilungskanäle.

- Apr 24, 2025 at 10:35 pm

- Diese Partnerschaft stellt eine signifikante Validierung von Stablecoins als Finanzinfrastruktur durch zwei börsennotierte Finanzinstitute dar.

-

- Legend Trading verbindet das Internet, Blockchain und Stablecoins, um die Grundlage für schnelle und effiziente grenzüberschreitende Zahlungen zu bilden

- Apr 24, 2025 at 10:35 pm

- Legend Trading, ein weltweit führender Anbieter im institutionellen Kryptohandel, kündigte heute seine strategische Expansion in blockchainbasierte globale Zahlungen an

-

- Coinbase-Plattformen zur Bereitstellung von Gebührenfreien Einkäufen und einfach 1: 1-Einlösung von PayPal-USD, während Unternehmen gemeinsam neue Zahlungsanwendungsfälle für Zahlungen untersuchen

- Apr 24, 2025 at 10:30 pm

- Diese Zusammenarbeit bietet Verbrauchern, Unternehmen und Institutionen einen Mehrwert, da sie weiterhin digitale Währungen über Plattformen und Grenzen hinweg nutzen

-

-

-

-

-

- Pepe zieht sich 5% zurück, nachdem er den Widerstand in der Nähe von 0,00000936 US -Dollar erreicht hat. Die Walakkumulation weist auf eine potenzielle Erholung in Richtung 0,00001025 USD und möglicherweise $ 0,00001584 hin.

- Apr 24, 2025 at 10:20 pm

- Während der Kryptomarkt einen Intraday -Rückzug erfährt, blinkt das Meme -Münzsegment rot. Die Gesamtmarktkapitalisierung des Meme -Münzsektors ist um 3,47% auf 52,05 Mrd. USD gesunken.

-

- Bitcoin (BTC) -Dominanz als Zufluchtsort innerhalb von Crypto mag zur Debatte bereit sein, aber innerhalb von Crypto ist es kaum fragwürdig

- Apr 24, 2025 at 10:15 pm

- Die Preise für Kryptowährungen sind in den letzten 24 Stunden auf die gesamte Board gesunken, aber die Wetten auf die Dominanz von BTC wachsen weiter.