|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

今日のブログ投稿で、Apple エンジニアは、大規模な言語モデルでより高速なテキスト生成パフォーマンスを実装するための NVIDIA とのコラボレーションに関する新しい詳細を共有しました。

Apple engineers have shared new details on a collaboration with NVIDIA to implement faster text generation performance with large language models (LLMs).

Apple のエンジニアは、大規模言語モデル (LLM) によるより高速なテキスト生成パフォーマンスを実装するための NVIDIA とのコラボレーションに関する新しい詳細を共有しました。

Earlier this year, Apple published and open sourced its Recurrent Drafter (ReDrafter) technique, a new method for generating text with LLMs that’s significantly faster and “achieves state of the art performance.” It combines two techniques: beam search (to explore multiple possibilities) and dynamic tree attention (to efficiently handle choices).

今年の初め、Apple は Recurrent Drafter (ReDrafter) 技術を公開し、オープンソース化しました。これは、LLM を使用してテキストを生成するための新しい方法であり、大幅に高速で「最先端のパフォーマンスを実現」します。これは、ビーム探索 (複数の可能性を探索するため) と動的ツリー アテンション (選択を効率的に処理するため) という 2 つの技術を組み合わせたものです。

While its research demonstrated strong results, Apple also collaborated with NVIDIA to apply ReDrafter in production. As part of this collaboration, ReDrafter was integrated into NVIDIA TensorRT-LLM, a tool that helps run LLMs faster on NVIDIA GPUs.

その調査で強力な結果が実証された一方で、Apple は NVIDIA と協力して ReDrafter を実稼働環境に適用しました。このコラボレーションの一環として、ReDrafter は、NVIDIA GPU で LLM をより高速に実行するのに役立つツールである NVIDIA TensorRT-LLM に統合されました。

Here are the results:

結果は次のとおりです。

To enable the integration of ReDrafter, NVIDIA added new operators or exposed existing ones, which considerably improved TensorRT-LLM’s capability to accommodate sophisticated models and decoding methods. ML developers using NVIDIA GPUs can now easily benefit from ReDrafter’s accelerated token generation for their production LLM applications with TensorRT-LLM.

ReDrafter の統合を可能にするために、NVIDIA は新しい演算子を追加するか、既存の演算子を公開しました。これにより、洗練されたモデルとデコード手法に対応する TensorRT-LLM の機能が大幅に向上しました。 NVIDIA GPU を使用する ML 開発者は、TensorRT-LLM を使用した実稼働 LLM アプリケーションに対する ReDrafter の高速化されたトークン生成の恩恵を簡単に受けられるようになりました。

In benchmarking a tens-of-billions parameter production model on NVIDIA GPUs, using the NVIDIA TensorRT-LLM inference acceleration framework with ReDrafter, we have seen 2.7x speed-up in generated tokens per second for greedy decoding. These benchmark results indicate this tech could significantly reduce latency users may experience, while also using fewer GPUs and consuming less power.

NVIDIA TensorRT-LLM 推論アクセラレーション フレームワークと ReDrafter を使用して、NVIDIA GPU で数百億のパラメーター生成モデルのベンチマークを行ったところ、貪欲なデコードで 1 秒あたりの生成トークンの速度が 2.7 倍向上したことがわかりました。これらのベンチマーク結果は、この技術によりユーザーが経験する可能性のある遅延を大幅に削減できると同時に、使用する GPU の数と消費電力も削減できることを示しています。

“LLMs are increasingly being used to power production applications, and improving inference efficiency can both impact computational costs and reduce latency for users,” Apple’s machine learning researchers conclude. “With ReDrafter’s novel approach to speculative decoding integrated into the NVIDIA TensorRT-LLM framework, developers can now benefit from faster token generation on NVIDIA GPUs for their production LLM applications.”

Apple の機械学習研究者は、「実稼働アプリケーションを強化するために LLM が使用されることが増えており、推論効率の向上は計算コストに影響を与え、ユーザーのレイテンシを短縮することができます」と結論付けています。 「ReDrafter の投機的デコードに対する新しいアプローチが NVIDIA TensorRT-LLM フレームワークに統合されたことで、開発者は本番 LLM アプリケーション用に NVIDIA GPU でのより高速なトークン生成の恩恵を受けることができるようになりました。」

You can learn more about this work on Apple’s website and in a blog post on NVIDIA’s website.

この取り組みの詳細については、Apple の Web サイトおよび NVIDIA の Web サイトのブログ投稿でご覧いただけます。

免責事項:info@kdj.com

The information provided is not trading advice. kdj.com does not assume any responsibility for any investments made based on the information provided in this article. Cryptocurrencies are highly volatile and it is highly recommended that you invest with caution after thorough research!

If you believe that the content used on this website infringes your copyright, please contact us immediately (info@kdj.com) and we will delete it promptly.

-

-

-

-

-

-

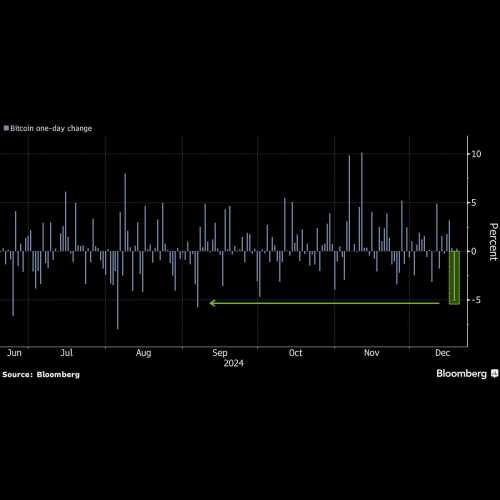

- FRBが警告後、ビットコインは3カ月以上で最も下落

- 2024-12-19 10:45:01

- 水曜日の5%以上の下落により、最大のデジタル資産は注目の水準である10万ドルに近づいた。

-

-

-